ARA-2の開発を進める謎の会社Kinara AIプロセッサーの昨今

ASCII.jp / 2022年12月19日 12時0分

今週お届けするのはKinaraなのだが、この会社は少なくとも2022年3月まではDeep Vision, Incという社名であった。ただインターネットアーカイブで調べると、2022年5月以降はKinaraにウェブページがリダイレクトされるようになっている。4月か5月あたりに社名変更をしたらしいが理由は不明である。なにしろ社歴を見ても社名変更の理由どころか、Deep Visionの名前すら出てこない有様である。

創業者はRehan Hameed博士(当初はCEO、現在はCTO)とWajahat Qadeer博士(Chief Architect)の2人。両博士とも、KinaraというかDeep Vision創業前はスタンフォード大学で研究助手を務めており、どうもこの頃に出会ったらしい。

実は両博士は共同でいくつかの論文を出しており、この論文で論じた仕組みを商用化するために作ったのがDeep Visionだったようだ。もっとも最初の論文である“Understanding sources of ineffciency in general-purpose chips”は筆頭著者がHameed博士、共著者がQadeer博士のものだが、これは文字通り汎用プロセッサーの不効率性を分析したもので、この際のターゲットはH.264のエンコードの際の効率を論じたものである。

ただこの後、2013年に出された“Convolution engine: balancing efficiency and flexibility in specialized computing”は、今度は筆頭著者がQadeer博士、共著者がHameed博士になっているが、文字通り畳み込み処理を効率的かつ柔軟に行なうための仕組みについて論じたものであり、これが同社のARA-1チップの基本になっている。

その論文の中身であるが、これもやはりH.264のエンコードを高速化するというテーマである。2013年に発表された論文なので、まさに論文を書いている最中に2012年のILSVRCでトロント大のImageNetが出てきたタイミングであり、まだこの時点ではAIを意識していなかったものと思われる。

そもそもH.264のエンコードで9割以上の作業はMotion Estimation(動き推定)である。これは前フレームの画像と現フレームの画像を比較して、その画面の中(あるいは画面全体)の動きベクトルを計算するものだが、通常は画像ブロック(4×4ピクセルや8×8ピクセルなどが一般的だが、もっと違うサイズのブロックの指定も可能)単位で、フレーム間でどこに動いたかを比較するわけで、比較というのは前画像のあるブロックと同じ(あるいは近い)構成のブロックがどこにあるかを現画像を舐めて推定するという、大変に手間のかかる作業である。

もちろんいろいろ高速化の技法はあるが、高速化と精度の低下がバーターの関係に近いため、あまり大胆な高速化は画質の劣化やデータ量の増大につながる。したがって画質を保ち、データ量を増やさないためには愚直に画像比較を行なうしかない。この画像比較が全体の9割を占めているというわけだ。

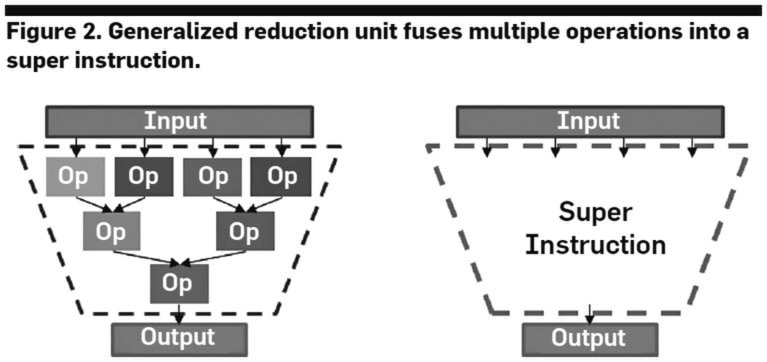

で、この画像比較に畳み込みを使うのだが、畳み込みと言うのは例えば下の画像の左側のような処理になるわけで、これを一気に行なえるような「超命令」を利用すれば処理量が減る、というのが論文の骨子である。

実際には畳み込み「だけ」で動き推定が行えるわけではないが、動き推定の中で畳み込みの処理量がかなり多いのは事実で、これを効率化することで高性能と低消費電力化が図れるとする。

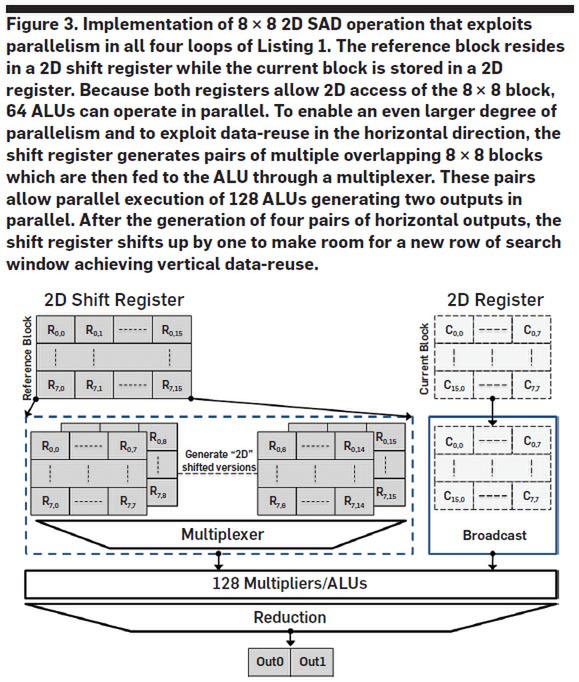

実際に8×8の2次元SAD(Sum of Absolute Difference:差分絶対値和)を計算するための構成が下の画像だ。

ちなみに動き推定というのは、あるブロック同士の比較をして終わるわけではなく、例えばSD映像(720×480)なら極端な話、34万5600回の比較することになる。この際に毎回前画像のブロックと現画像のブロックをロードするのは非効率なので、元画像のブロック(2D Register)と、現画像のブロック(2D Shift Register)のデータは再利用できるように工夫されている。

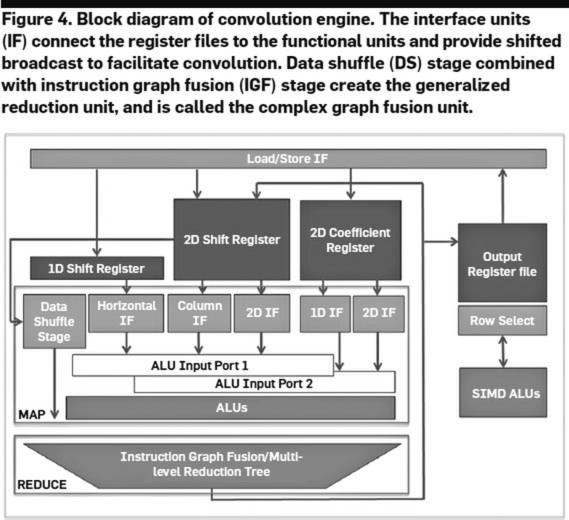

元画像は8×8ピクセルなのに、現画像は16×8ピクセルになっているのがそれで、この2D SADエンジンでは横8ピクセル分の移動のベクトルを4サイクルで算出できることになる。この2D SAD以外の動作にも対応した畳み込みエンジン(Convolution Engine)と呼ばれるものの全容が下の画像だ。

SADでいうなら、MAPが8×8で64個のピクセル単位の差の絶対値を計算する部分、REDUCEがその総和を取る部分で、畳み込みなら乗加算をMAPで、その後の活性化やサブサンプリングがREDUCEに当たる部分になる。

実際に論文の中では、(ちょうどこの論文が出たころにCadenceに買収された)CPU IPのベンダーであるTensilicaがリリースしていたシミュレーションプラットフォームを利用してこの畳み込みエンジンを実装した場合の評価をしており、専用のASICに比べれば効率はやや落ちるものの、SIMDを利用した場合に比べると大幅に効率が良かったことを報告している。

この論文が出た頃には第3次AIブームが巻き起こっており、しかもそこで利用されている技術は、両博士が得意としていた畳み込み演算が主体である。であれば当然利用できるはず、と考えたのは不思議でもなんでもない。そこで、AIプロセッサーの構築に向けて立ち上げたのがDeep Visionというわけだ。

ちなみに冒頭で当初のCEOはHameed博士と書いたが、スタートアップ企業のCEOにはさまざまなビジネス上の面倒ごとが降りかかってくる。それもあってか、2015年3月からはAppleでGroup Product Managerを務めていたJason Copeland氏がCEOとして参加した。

同氏は、複数のベンチャーからの出資を受けたり、ビジネスプランの策定やスタンフォード大のStartXというベンチャー支援プログラムへの参加、最初のプロトタイプチップ作成あたりまでに付き合い、2017年1月に離職している。

出荷が始まったARA-1 ただし製品の詳細は不明

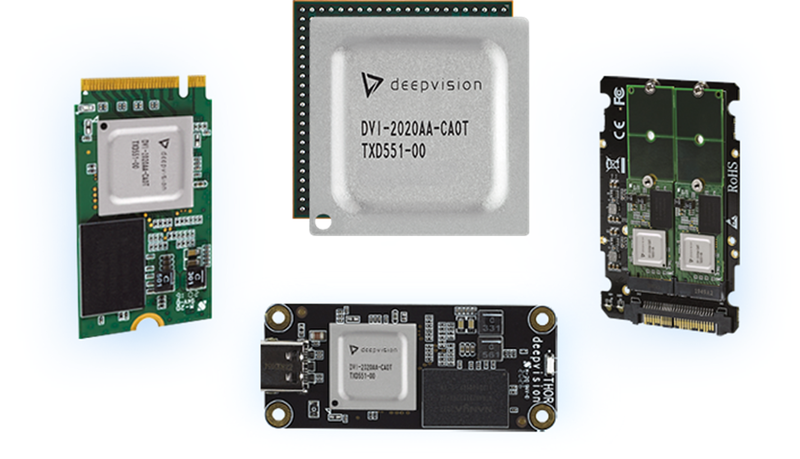

量産チップであるARA-1の出荷が始まったのは2020年11月で、チップ単体だけでなくUSBモジュール/M.2モジュール/U.2モジュールの出荷も開始された「らしい」。

なぜ「らしい」なのかというと、チップ単体およびUSB/M.2モジュールに関してはすでにProduct Briefがダウンロード可能なのに対し、U.2モジュールのみメールでお問い合わせという扱いになっているためだ。またこれとは別に、EVK(評価キット)も用意されているようだが、こちらも詳細は不明である。

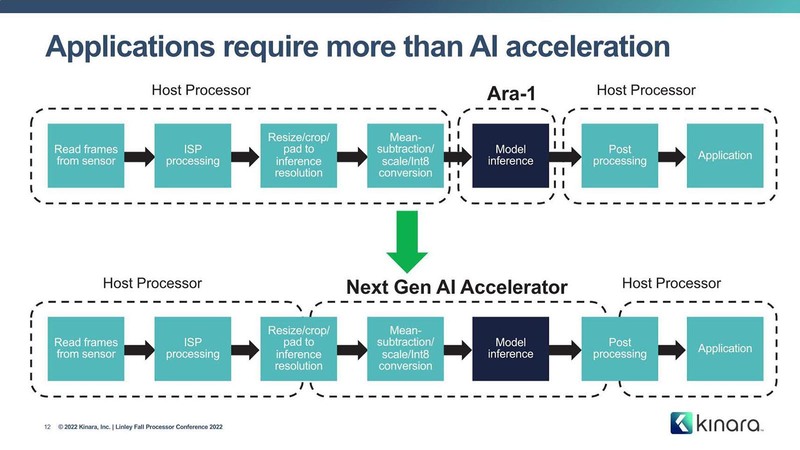

さてこのARA-1の内部構造の詳細も、Kinaraは依然として公開していない。今年11月に開催されたLinley Processor Conference Fall 2022において同社としては初めて製品発表をしたのだが、その中でも製品の詳細については一切語られないという不思議なものであった。

ただこれに先立ってKinaraはいくつかのビデオを公開している。アクションカメラに組み込んでリアルタイムに認識させるデモや、複数のビデオストリームに対して複数のネットワークを実施するデモ、ビデオカンファレンス用の仮想背景の実装、E-フィットネス、車載向けのセグメンテーションデモなど。最新のものは、8月に公開されたスマートショッピングのシステム向けデモである。

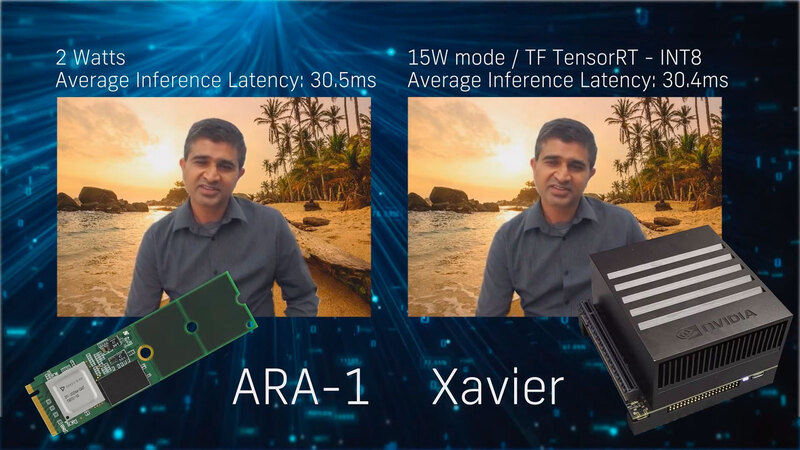

スマートショッピング以外の動画を見ると、まだARA-1チップにDeep Visionのロゴがあるのがおもしろいがそれはさておき、例えば仮想背景ではインテルのNUCにM.2モジュールを1枚装着して実施した場合と、NVIDIAのXavierを利用した場合を比較して、どちらも平均30ms程度のレイテンシーながら消費電力は15W→2Wと大幅に削減できていることを示した。

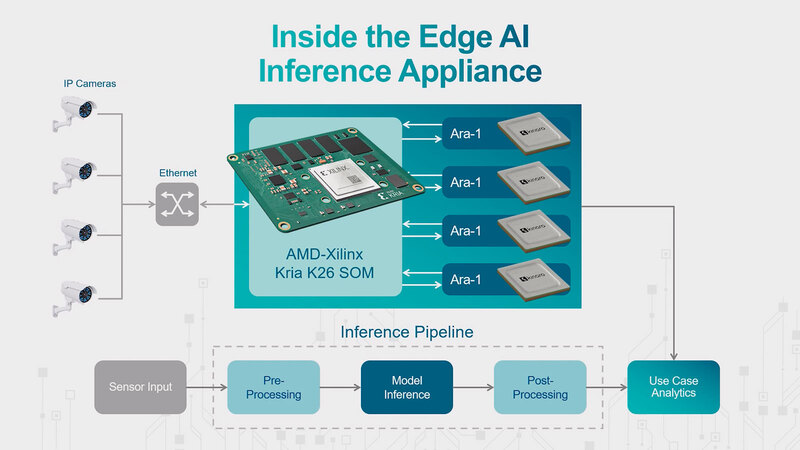

スマートショッピング向けには、AMD/XilinxのKria K26というZynq UltraScale+ FPGAが載ったSOM(System On Module)に4枚のARA-1 M.2モジュールを組み合わせた構成であるが、これで最大16本のフルHD H.264動画の処理が可能とされている。

ARA-1の性能そのものは、600MHz駆動のものと800MHz駆動のものがあり、おそらくこの800MHz駆動のケースでResNet50で100推論/秒、Mobilenetで554推論/秒の性能とされる。正直性能そのものでいえばそれほど高いものではない。とはいえ、すでに量産品が18ヵ月にわたって出荷されているというのはそれなりに大きなインパクトがある。

後継機のARA-2が2023年に発表予定

今回のLinley Processor Conference Fall 2022に話を戻すと、Kinaraはすでに動作するARA-1が販売されているという話に続き、より性能を拡充したARA-2を開発中であるとのこと。他にも、例えばホストとの通信の暗号化や、より柔軟なソフトウェアの対応が可能な仕組みの搭載なども同時に予定しており、2023年に製品発表を目指しているという。ここまで説明していながら、肝心の内部詳細は引き続き未公開というあたりがやや引っかかる。

実はこのKinara、気が付いたらMarkus Levy氏が2021年5月からVP, Business Development and Marketingとして加わっていた。Levy氏、もともとはEEMBCという組み込み業界向けのベンチマークを提供する団体を立ち上げて21年もの間経営した(まだ存在する)のだが、その後突如としてNXPに移籍。Director of AI and Machine Learning Technologiesという肩書でNXP製品へのAI機能搭載に尽力していたはずだったのが、そのNXPを2020年末に退職して、Kinaraに移籍した格好になる。

EEMBC時代からLinley Processor Conferenceを主宰するLinleyグループが発行するLinley Processor Reportや、そのフォーマットの原型となった(MicroProcessor Forumを主宰していた)MicroDesignが開催していたMicroProcessor Forumにたびたび筆者/講演者として参加してさまざまなレポートや講演を行なっていた人物でもあり、その意味でわりと業界内部では有名人である。

そうしたLevy氏が参画している理由が、単に客寄せパンダとはやや考えにくいわけで、なにかしらあるだろうという気はするのだが、それが具体的に見えてこないあたり、今後の情報公開を期待したいところではある。まずはARA-2がきちんと出荷されることを確認するのが最初であろうか?

この記事に関連するニュース

-

アヴネット、EdgeTech+ 2024で革新的なエッジAIソリューションを披露

PR TIMES / 2024年11月20日 13時40分

-

小型AIスマートカメラモジュール『SCMシリーズ』をリリース

共同通信PRワイヤー / 2024年11月14日 16時0分

-

わずか2年で完成させた韓国FuriosaAIのAIアクセラレーターRNGD Hot Chips 2024で注目を浴びたオモシロCPU

ASCII.jp / 2024年11月11日 12時0分

-

Metaが自社開発したAI推論用アクセラレーターMTIA v2 Hot Chips 2024で注目を浴びたオモシロCPU

ASCII.jp / 2024年11月4日 12時0分

-

Appleはなぜ“Mac週間”でラインアップを更新したのか 透けるIntelチップからのリプレースとAIへのこだわり

ITmedia PC USER / 2024年10月31日 12時5分

ランキング

-

1リンク付き投稿は拡散力減?イーロン氏明かすXルール 「告知投稿めっちゃ影響」不満も続々

J-CASTニュース / 2024年11月26日 17時11分

-

2『ドラクエ3』大魔王ゾーマ様、配信者になる―自己紹介では「嫌いなもの:ひかりのたま」とポロリ、「“ほりい”とかいう人間も泣き叫んでた」

インサイド / 2024年11月26日 13時10分

-

3東芝マテリアルを日本特殊陶業が買収 1500億円で

ITmedia NEWS / 2024年11月26日 12時44分

-

4HD-2D版『ドラクエ3』勇者「俺だけバラモス倒せなかった…」←なんで? 嘆きの声続出の理由

マグミクス / 2024年11月25日 17時25分

-

5オリエンタルランド、東京ディズニーリゾート販売の“3800円のマイボトル”回収 対象個数は4240個…… 「ご迷惑とご心配」

ねとらぼ / 2024年11月26日 17時12分

記事ミッション中・・・

記事にリアクションする

![]()

記事ミッション中・・・

記事にリアクションする

エラーが発生しました

ページを再読み込みして

ください