アップルWWDCで明かされたのは「パーソナルインテリジェンス」への挑戦だった(西田宗千佳)

ASCII.jp / 2024年6月13日 7時0分

今年のWWDCは「アップルAI祭り」になるのが必然だった。というか、そうでなかったら、アップルは「AIに関する取り組み」戦略で大変なダメージを負っていただろう。

しかし、今回は予告通り、AIが主軸の発表になった。技術的に見れば、去年のVision Pro発表以上におもしろい内容だったと感じている。

一方、アップルの生成AI技術である「Apple Intelligence」は、まだ正しく理解されていないのではないかとも感じる。その証拠に、基調講演後には株価がグッと下がったものの、この記事を書いている6月11日(アメリカ時間)現在は大幅に上がっている。どういうものなのかが見えてきたから持ち直したのではないか……と考えている。

ではApple Intelligenceとはどんな存在なのか?

機能的な部分・技術的な部分を、基調講演後のリサーチから得られた内容を含め、解説していく。

生成AIが「次のUI」に必要である理由

Apple Intelligence搭載の前、すでに現在もアップル製品には多数のAIが搭載されている。顔認識や音声認識が典型的な例だが、すでにOS内には200以上のAIモデルがあり、多くの機能で使われている。

これはアップルに限ったことではない。AndroidでもWindowsでも、AIを使った機能はすでに多数ある。ただし、それらで使われているのは、いわゆる生成AIではない。

本質的な話として、生成AIであるかそうでないかは大きな意味を持たない。現在のAIである以上処理は似ているし、消費者にとって重要なのは「便利になること」であり、どんな技術であるかではない、というのも一つの正論である。

一方、高度な文脈理解・人間的な応答には、処理負荷の高い生成AIを使うのが望ましい。それをいかに機器とOSの中に組み込み、多くの人が便利に使える形を目指すか……というのが現在の競争軸である、と言っていい。

別の言い方をすれば、「空欄にプロンプトを入れる」ところから脱却し、生活に密着して毎日使える生成AIの実装をどう進めるのかが重要ということになる。

パーソナルインテリジェントへ「4度目の挑戦」

その中でアップルは明確に「利用者によりそう」ことを目指した。それを明確に示している言葉もある。

アップルのティム・クックCEOは、基調講演の最後にApple Intelligenceを「パーソナルインテリジェンス」と呼んだ。「Apple Intelligence=AI」というのは名前として洒落ているが、本質的に目指そうとしているのは、個人のための知的な存在ということなのだろう。

「パーソナルインテリジェンス」的な世界は、パーソナルコンピュータの発明以来ずっと夢見られてきたことだ。アップルに関していうなら、1987年に提唱された「ナレッジナビゲーター」がそうだし、現在の音声アシスタントである「Siri」もそうだろう。Macintoshが目ざしていたもの自体も、結局のところ「自分の作業を助けてくれる存在」ということになる。

ただそうした試みは、常に技術の限界という壁に阻まれてきた。PC/Macは道具にはなったが、人間の相棒ではないし、ナレッジナビゲーターは実現しなかった。Siriもずいぶん賢くはなったが、現状では「声で動かすリモコン」の域を脱していない。

今度はパーソナルインテリジェンスとして、生成AIを軸として再度、同じテーマに挑もうとしている。

ただ過去と違うのは、そのための機器を作る訳ではなく、「自分の周りにある、あらゆるアップル製品がそれぞれパーソナルインテリジェンスになる」というところだ。

「ペンで書いて数式処理」は生成AIを使っていない

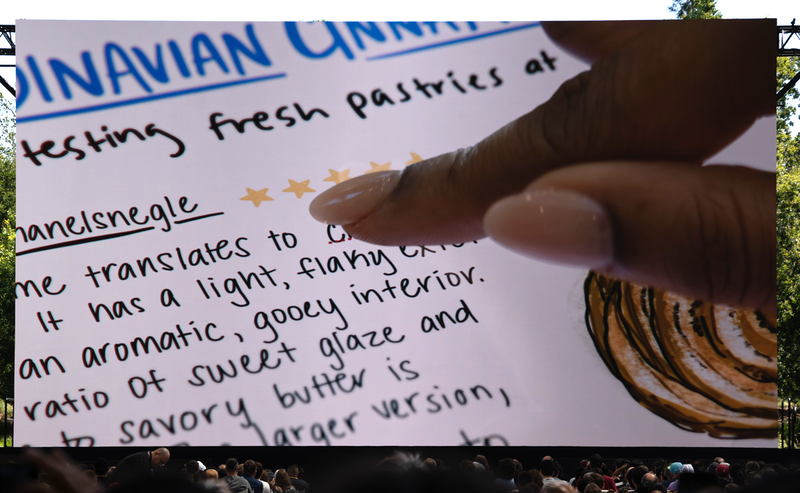

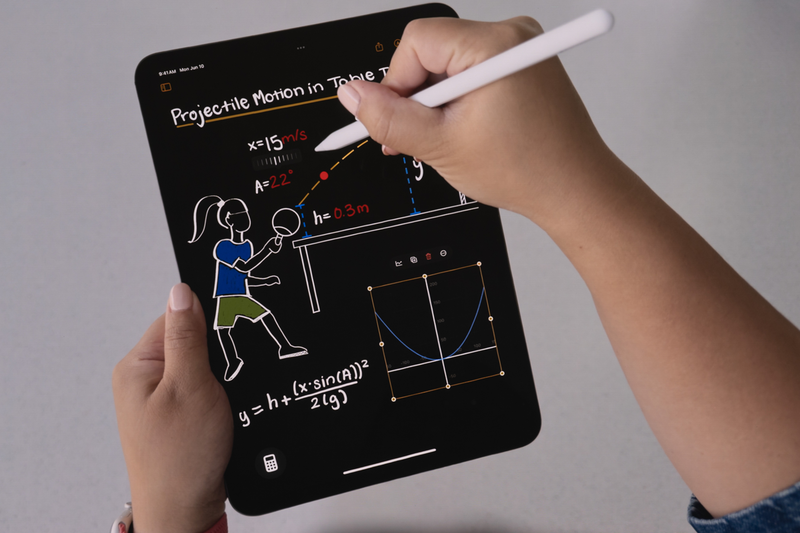

そこでおもしろい要素がある。iPadの次期OSであるiPadOS 18には、「Smart Script」という機能がある。

これはペンで手書きした文字のくせを把握して「自分のくせ文字」を学習する機能だ。そうすると、タイプした時でもそのくせ文字を出せるし、テキストを修正する時の感覚で文字を消したり追記したりできる。

さらに新しく搭載された「計算機」アプリは、手書きで数式などを書いていくとSmart Scriptで整理し、内容を計算し、グラフ化までしてくれる。一部の数字や数式を書き換えた場合、その内容に合わせて再計算とグラフの書き換えもする。

まるでノートがインテリジェントになったようで、いかにも「Apple Intelligence……」と感じそうだ。

だがこの機能はApple Intelligenceではなく、OSの中にある一般的なAIで動いている。だから、「Mシリーズ搭載のiPad」でなくても動作する。

Apple Intelligenceでなくても便利な機能だが、明確な違いとして「計算はしてくれるがその計算式や数字を書くのは自分だ」という点がある。技術のコアは手書き文字認識であり、その先で計算などを自動化しているだけなのだ。

生成AIに依頼して同じようなことをする場合には、一般的には「質問を認識し、それがどんな問題かを考え、説明を含めた回答を作る」というプロセスになる。要は「便利なノート」と「質問に答えてくれる機械」というベクトルの違いが存在するわけだ。

アップルは道具としての前者を用意しつつ、Apple Intelligenceで後者も作ろうとしている。

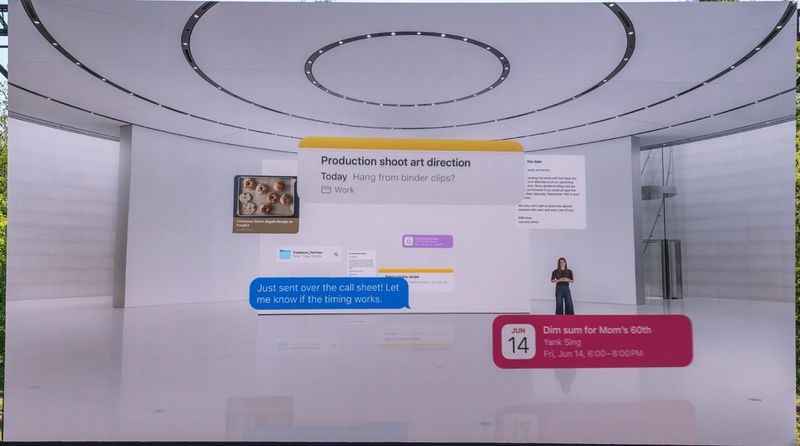

アプリをまたいで「履歴」「文脈」「コンテンツ理解」

では、Apple Intelligenceの目指すものはどのように実現され、どこが大きな要素となるのだろうか?それは「アプリをまたいだ履歴と文脈の理解」であり、「アプリ内のデータに関する深い理解」である。

Apple Intelligence導入後の新しいSiriでは、次のようなことができる。

「前話してた試合、どの球場でやってるんだっけ?」 「そこまでって、どのくらいかかる?」 「場所を覚えておいて」

人間との会話だったらあたりまえの内容だ。だが機械への指示だとすると、

・どのスポーツの話をしていたのか ・話している球場とはどこを指すのか ・場所を覚えるとは、どのアプリへの記録を指すのか

といった情報が本来は必要だし、それぞれどのアプリで実行するべきかも、指定しなければならない。

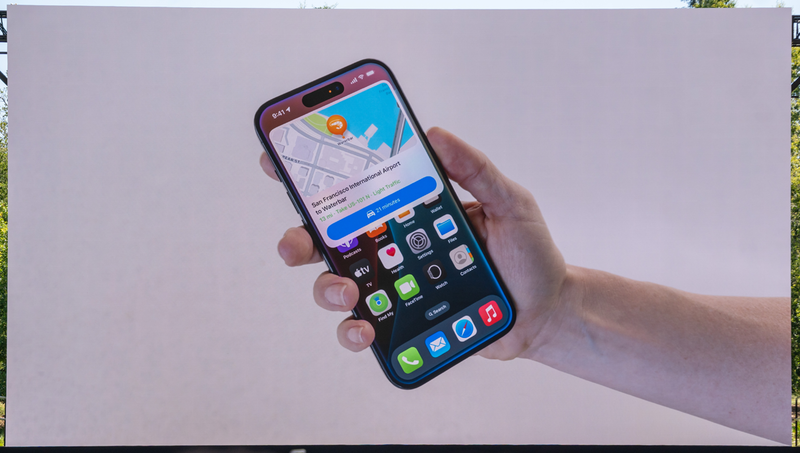

だがApple Intelligenceの場合、端末内でのコミュニケーション履歴やアプリの機能から適切な情報を選び、会話が成立している間は「読まねばならない文脈」を抑えて働く。

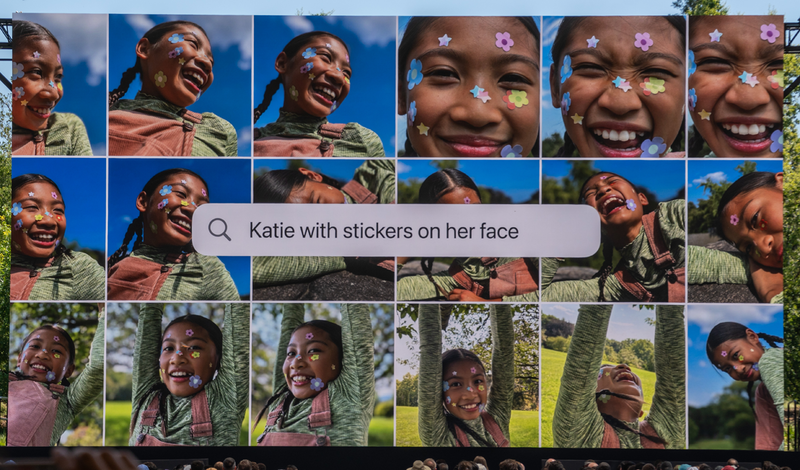

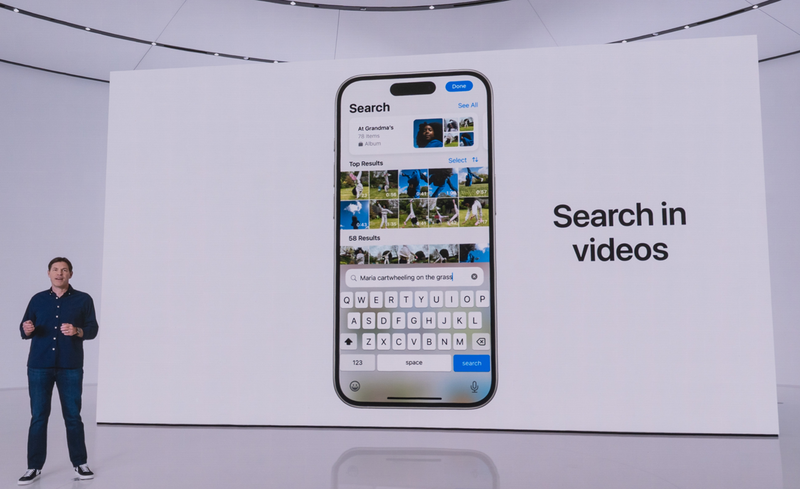

また、「写真」アプリもおもしろい。アプリ内に蓄積された写真・動画について、なにが写っているのかを全て検索用のインデックスとして生成し、検索対象とするのだ。

だから例えば、「東京に行った時食べたもの」「釣りをしている子ども」のようなふんわりフレーズで検索可能にする。

また動画の場合、サムネイルだけでなく「動画内に含まれるもの」まで検索対象として解析されるため、大量の動画から決定的シーンが含まれるものを見つけられるわけだ。

さらには、写真・動画をまとめる「メモリー」機能の場合、「登山旅行の写真を。〆は2人のセルフィーで」と指定することで、ちゃんとセルフィーで終わるショート動画にまとめ直してくれたりもする。

こうした要素がどのくらいデバイスの使い勝手を変えていくのかは、正直なところ未知数だ。非常におもしろい要素ではあるが、そんなにうまくは働かない可能性もある。

だが少なくとも、「アラームを7時……んー、6時にセットして」という感じで言い淀んだ場合でも、ちゃんと人間と同じように「6時にセット」してくれるようだ。「6時と7時の2つセットされる」のでも、「7時にセットされる」のでもない。

この時点で、今までとは違う世界に入りつつあると感じないだろうか。

独自開発でプライバシーを重視

「アプリをまたいだ履歴と文脈の理解」と「アプリ内のデータに関する深い理解」を実現するには、アプリ同士で文脈を引き継いで動作する方法を用意しつつ、生成AIによってデバイス内のインデックスを作る必要がある。

要はそれをやるのがApple Intelligenceということになる訳だが、アプリやメッセージの履歴にしろ、写真・動画のインデックスにしろ、その人のプライバシーがまるごと詰まった情報と言える。

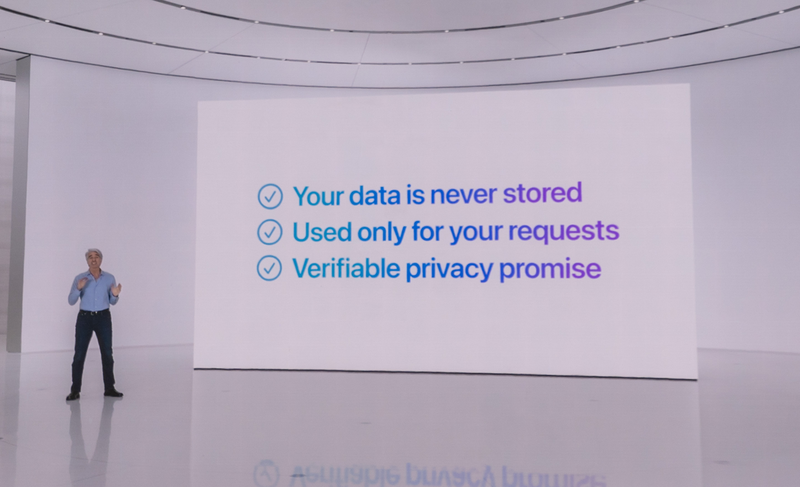

それをクラウドで、事業者に預けて処理するのは非常にリスクが高い。誰にも知られたくないことは、デバイスの中だけで処理されるのが望ましい。

だからオンデバイスAIが注目されている訳だ。

一方でアップルはもうずっとプライバシー重視を標榜し、2019年には以下のような広告をラスベガスに掲載したこともある。

「iPhoneの中で起きたことはiPhoneの中にしかない」

多分にグーグルを意識したものではあるのだが、この考え方はApple Intelligenceでも引き継がれている。

AIの使う情報・インデックス化はデバイスの中で実行され、デバイスの外には出ない。iCloudで同期されることもない。ただ、処理負荷がデバイス内で追いつかない場合などには、匿名化した情報を「短期的に、そのデバイスのリクエストのためにプライベートエリア化したクラウド」で処理する。そして、速やかに削除し蓄積しない。

こうすることで、オンデバイスAIのメリットを活かしながら、それ以上のパワーでの処理もして実用性を高める仕組みになっているのだ。

アップルが使う生成AIは、数年前から自社開発した「AXLearnフレームワーク」(2023年にオープンソースとして公開)で構築されたもので、文字などはウェブ上のコンテンツを使ってトレーニングされている。その上で、画像生成などでは「ライセンスを得たコンテンツ」を使って追加のトレーニングを行ったとされる。

アップルは「他社に対してパフォーマンスでも優位」というレポートを出しているが、その検証も今後必要となるだろう。「プライバシー+独自開発」を軸にすえたAIがどれだけ他社との違いを生み出せるのか、英語版でのテストが始まる秋が楽しみだ。

筆者紹介――西田 宗千佳 1971年福井県生まれ。フリージャーナリスト。得意ジャンルは、パソコン・デジタルAV・家電、そしてネットワーク関連など「電気かデータが流れるもの全般」。取材・解説記事を中心に、主要新聞・ウェブ媒体などに寄稿する他、書籍も多数執筆。テレビ番組の監修なども手がける。主な著書に「生成AIの核心:「新しい知」といかに向き合うか」(NHK出版)、「メタバース×ビジネス革命 物質と時間から解放された世界での生存戦略」(SBクリエイティブ)、「ネットフリックスの時代」(講談社)、「ソニー復興の劇薬」(KADOKAWA)などがある。

この記事に関連するニュース

-

アップル、Mac刷新"メモリ倍増"が示す戦略的意志 「生成AI時代」に対応した製品ポートフォリオ

東洋経済オンライン / 2024年11月7日 9時30分

-

日本で「Apple Intelligence」を使う方法 英語設定なら試せる

ITmedia NEWS / 2024年10月29日 12時16分

-

「Apple Intelligence」の一部機能、英語設定なら日本でも利用可能に

ITmedia Mobile / 2024年10月29日 8時59分

-

Apple Intelligenceの最初の機能が利用可能に 使うにはデバイスとSiriの言語を英語にする必要あり

ASCII.jp / 2024年10月29日 2時10分

-

3年ぶりの刷新、AIにも対応「iPad mini」は買いだ ただし「Apple Pencil」は買い替える必要あり

東洋経済オンライン / 2024年10月23日 9時40分

ランキング

-

1330円で買ったジャンクのファミコンをよく見ると……!? まさかのレアものにゲームファン興奮「押すと戻らないやつだ」

ねとらぼ / 2024年11月16日 8時30分

-

2発熱する「iPhone 12 mini」のバッテリー、よく見ると膨張……街中の修理店で交換した結果は?

ITmedia Mobile / 2024年11月17日 10時5分

-

3「完全にセーラームーンの世界」 三日月とスカイツリーが織りなす“絶景”…… この世のものとは思えない美しさに驚異の“68万いいね”

ねとらぼ / 2024年11月17日 21時30分

-

4楽天市場、2024年11月21日からBLACK FRIDAYを開催

ポイ探ニュース / 2024年11月17日 15時57分

-

5「全部が完璧」 水辺に女神が降臨した“奇跡の瞬間”に「凄すぎて既に神」「綺麗すぎて言葉取れたわ」

ねとらぼ / 2024年11月17日 12時0分

記事ミッション中・・・

記事にリアクションする

![]()

記事ミッション中・・・

記事にリアクションする

エラーが発生しました

ページを再読み込みして

ください