未来のAIアシスタントは行動認識で「次はジャガイモ切って」と教えてくれる

ASCII.jp / 2024年8月2日 10時0分

- 研究実施者:笹崎海利、松井智一(奈良先端科学技術大学院大学)

- 研究テーマ:行動認識に向けた発話による宅内マイクロ行動クラス表現の検討

- 担当PM:井本桂右(同志社大学 文化情報学部 准教授)

マイクロ行動を分散表現として表現する画期的なアイデア

Amazon AlexaやGoogleホームのようなスマート・スピーカーを自宅で使っているだろうか。これらのデバイスは「AIアシスタント」とも呼ばれ、音声で呼びかけると天気を知らせてくれたり、設定した時間になると音声で教えてくれたりする。料理などの家事の最中に手が離せないときには便利なデバイスだが、もっと家庭内でのさまざまな「お手伝い」をしてくれるようにはならないのだろうか。

今よりも高度な家庭用アシスタントの実現に向けて鍵となるのが、自宅内での人間の行動(宅内行動)を正確に認識する技術だ。これまで研究されてきた宅内行動認識は、「洗濯をしている」「料理をしている」といった粒度の粗いマクロ行動に留まっており、家事の行動支援まで進むには、例えば「包丁で野菜を切っている」「フライパンで肉と野菜を炒めている」といった、より細かなマイクロ行動の認識が必要になる。

一方、これまでのマイクロ行動の認識に関する研究は、特定の工場内や移動時など、限られた場面での行動を対象としたものであり、あらゆる行動が起こりうる一般的な家庭内での生活行動認識には対応できていない。マイクロ行動の認識が難しい最大の理由は、認識するべき行動が無数にあるため、通常の機械学習における多クラス分類での問題定義が困難なことにある。

覚醒プロジェクトで「行動認識に向けた発話による宅内マイクロ行動クラス表現の検討」という研究テーマが採択された奈良先端科学技術大学院大学修士2年の笹崎海利さんと同助教の松井智⼀さんは、分散表現を用いてマイクロ行動を表現できないか? というアイデアを思いついた。分散表現とは、自然言語処理分野で以前から利用されている考え方で、単語の意味を数十次元から数百次元のベクトルとして表現するものだ。笹崎さんは、「行動を分散表現として表現し、解釈や計算を容易にする」というアイデアを次のように説明する。

「行動を0か1かというラベルで離散的にクラス分けをするのではなく、分散表現を使えば有限のベクトルで、例えば『ニンジンを切る』と『ゴボウを切る』では、似ているけど少し違う、といったことを連続的に表現できます」

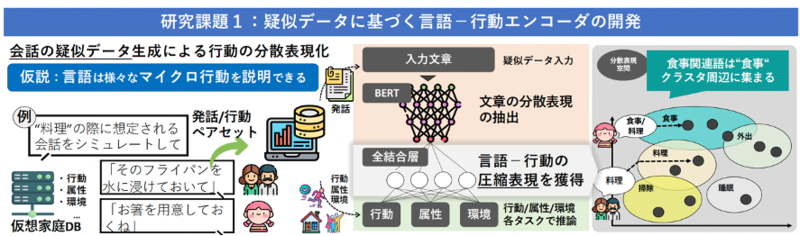

笹崎さんと松井さんは、宅内マイクロ行動認識の実現に向けて、2つの課題に取り組んでいる。1つは、マイクロ行動を分散表現として表すために、言語と行動を結びつける「言語-行動エンコーダ」の開発だ。笹崎さんは、そのためにChatGPTを活用するアイデアを思いついた。 「例えば、ChatGPTに『料理の際に想定される会話をシミュレートしてください』というプロンプトを入力すると、「包丁で野菜を切って」「皿を用意するね」などの会話が得られます。その文章を使って学習を行ない、文章から行動を推論する言語−行動エンコーダを作ります」

ChatGPTによって生成された会話を擬似データとして言語-行動エンコーダを学習させることで行動の分散表現を獲得することが、笹崎さんらの1つ目の研究課題である。笹崎さんによると、言語-行動エンコーダによる分散表現のベクトルの次元数は、当初32次元や64次元を想定していた。ただし、やや表現力に欠けることが分かってきたため、次元数を数百程度まで増やしたところ、エンコーダの性能が改善されたとのことだ。また、距離学習という手法を取り入れることによって、より優れた分散表現を獲得することができた。

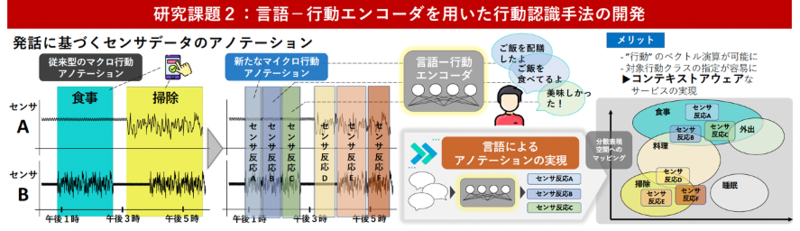

2つ目の研究課題は、言語-行動エンコーダを用いた行動認識手法の開発だ。最初に開発した言語-行動エンコーダを用いて、「食事」や「掃除」など実際の行動に対するセンサーデータに対してより細かくアノテーション(データに対して関連するメタデータを付与すること)を行なう。

笹崎さんらが所属する研究室は、宅内センシング・システムを備えたスマートハウスを所有しており、被験者の行動をさまざまなセンサーによって捉えることができる。あらかじめ被験者に、行動と同時に自分の行動を発話によって説明するように依頼しておくことで、行動に対するセンサーデータとその行動を説明した発話内容のペアデータが得られる。このペアデータを元に、先に開発した言語−行動エンコーダを用いて、センサーデータに対してマイクロ行動のアノテーションを行なう。

機械学習におけるアノテーションは正解データを付与することであり、通常は人間が作業するものだが、本プロジェクトでは、言語-行動エンコーダを利用することで、アノテーションを人間の自然な会話から獲得することを目指しているという点が新しい。

センサーデータに対するマイクロ行動のアノテーションが完了したら、そのデータセットを使ってマイクロ行動を認識するモデルを作ることを目指す。まずは、ステアラボと産総研によって公開された日常シーンの動画10万本とそのキャプションから構成されている「STAIR Actions キャプションデータセット」を使って実験を行った。その結果、似ているマイクロ行動は、行動の分散表現の距離も近いことが確認できる結果が得られたという。

マイクロ行動認識の実現で、きめ細かな行動支援が可能に

本研究が目指しているマイクロ行動認識が実現できれば、どのような応用が考えられるのだろうか。笹崎さんは次のように語る。

「ユースケースの1つとして、調理支援が考えられます。例えば、シチューを作る場合、具材を切って、炒めて、煮てと、さまざまなステップがあります。マイクロ行動を認識できると、『今はニンジンを切っていますね。では次は、ジャガイモを切って下さい』とか『切り終わったら、具材を鍋に入れて炒めて下さい』といった、今の行動を認識し、次の行動を教えてくれるサービスができるでしょう」

松井さんは、マイクロ行動認識の可能性について次のように説明する。

「マイクロ行動認識は、サービスを提供する会社にとっても大きなメリットがあります。例えば、タクシーの配車サービスの提供者が、自宅から外出の準備をしているという行動を認識したとします。この場合、外出準備をしていたとしても、自家用車を使って家族でレジャーに出かける場合は、配車準備は不要です。ですが、駅から新幹線を使って旅行に行くなら、駅までタクシーを使いたい。そこでタクシーを配車すれば喜んでもらえるわけです。同じような行動でも、微妙なコンテキストの違いによって提供されるサービスが変わる。こうした細かいニーズの獲得には従来の行動クラスの認識は不十分でした」

さらに、松井さんはその意義を次のように語る。

「行動認識は家庭ごとに必要なものだと考えています。家庭によって自宅の間取りや生活様式、習慣が異なるため、一般的なモデルはなかなか作れない。いくらGoogleやOpenAIが他人の生活データをたくさん集めても、自分の生活にフィットする行動認識モデルを作るのは難しいでしょう。ですから、将来的には自分の生活の中で正解データを自動的に獲得していく仕組みを検討する必要があるのです。このときに、提案手法のように、自然な会話を通して行動をアノテーションできることは大きなメリットとなります」

人の気持ちを理解し、生活を便利にしてくれる相棒を作りたい

笹崎さんらが採択された2023年度の覚醒プロジェクトは2024年7月までが実施期間だが、二人はプロジェクト期限までに1つ目の研究課題を終え、2つ目の課題の前半となる言語-行動エンコーダを用いた生活実験まで取り組む予定だ。現在までの成果をもとに、情報処理学会DPS研究会にて発表を行った。さらに、研究は覚醒プロジェクトの期間終了後も継続し、その成果を国際学会で発表することを目指している。

「1つ目の課題については、ChatGPTによる擬似データ生成に成功した段階で、情報処理学会関西支部の支部大会に投稿し、すでに発表しています。最終的な目標であるマイクロ行動認識手法が確立できた段階で、また国際学会で発表したいと考えています」(松井さん)

最後に、笹崎さんと松井さんに将来的な目標について尋ねてみた。

「最終的には、情報通信技術を使って、人でなくてはできないことに人が携わるような社会を作りたい。逆に言えば、人じゃなくてもいいもの、機械や情報通信技術に任せられるものは、それらが担えるようにしたい。そうした社会の実現が個人的な目標です」(笹崎さん)

「人の気持ちを理解したり、人の生活を便利にしてくれたりする存在——たとえばAIかもしれないですし、実体を持つロボットかもしれません——が共存する未来がいずれやってくるでしょう。そうした未来がやってきたときに、自分だけの相棒、パーソナル・アシスタントのような存在がいれば、楽しくなるのではないでしょうか。企業や他人から与えられた知識ではなく、自分が会話したり、教えたりすることで、自分だけのものとして成長してほしい。そこにやっぱりロマンを感じますね。今回の研究は家庭内での生活というプライベートな領域に関するものですが、そうした日常生活を便利にしてくれるものはやはり発話から学んでパーソナライズされていく。最終的には本当に自分に合ったアシスタントが作れたらいいなと考えています」(松井さん)

■覚醒プロジェクト 公式Webサイト http://kakusei.aist.go.jp/

この記事に関連するニュース

-

オルツ、大規模言語モデルを活用した超高速音声対話システム「altTalk」を発表

PR TIMES / 2024年11月14日 17時45分

-

オルツ、大規模言語モデルを活用した超高速音声対話システム「altTalk」を発表

共同通信PRワイヤー / 2024年11月14日 15時20分

-

フューチャー、国際的な機械翻訳のコンペティションにおいて日中翻訳で世界一位、英日翻訳で世界二位の品質評価を獲得

PR TIMES / 2024年11月14日 13時0分

-

Cohesity、生成AI会話型検索アシスタントの可視化ツールとデータソースを拡張

マイナビニュース / 2024年10月28日 13時57分

-

コミュニケーション可視化サービス「VUEVO」が2024年度グッドデザイン賞を受賞

PR TIMES / 2024年10月16日 17時45分

ランキング

-

1「これはひどい」 駐車場は“鳥のマーク”の階→元に戻ると…… “まさかの結末”に絶望 「なんてこった」

ねとらぼ / 2024年11月14日 19時30分

-

2みずほと楽天の資本業務提携で何が変わる? 対面×デジタルの強みを掛け合わせ、モバイル連携は「できない」

ITmedia Mobile / 2024年11月14日 18時30分

-

3AIがいい感じに仕上げてくれる「写真」文字盤 - Apple Watch基本の「き」Season 10

マイナビニュース / 2024年11月14日 11時30分

-

4「レールガン」研究の近況、装備庁が発表 “弾丸の安定した飛翔”に成功 電源の小型化も検討中

ITmedia NEWS / 2024年11月14日 8時5分

-

5これぞZ世代を体現したノートPC! NEC、エモいがテーマの「LAVIE SOL」

ASCII.jp / 2024年11月14日 20時0分

記事ミッション中・・・

記事にリアクションする

![]()

記事ミッション中・・・

記事にリアクションする

エラーが発生しました

ページを再読み込みして

ください