2025年のREGZAは「生成AI対応」へ、まるで人と話すように使える「レグザインテリジェンス」に期待だ

ASCII.jp / 2025年1月6日 10時6分

TVS REGZAは1月6日、CES 2025の技術展示の内容を公表した。

注目は「レグザインテリジェンス」と命名したAI活用のコンセプトだ。「生成AIボイスナビゲーター」として、業界に先駆けて生成AI機能を採用。アプリやリモコン操作など複雑な手順を経ず、テレビの前に立って音声認識でテレビと会話するだけで、膨大な数に及ぶ録りだめた番組やネットで公開されている動画の中から最短で最適なコンテンツを探し出せるようになるという。

言葉で質問するとすぐに自然な答えが返ってくる

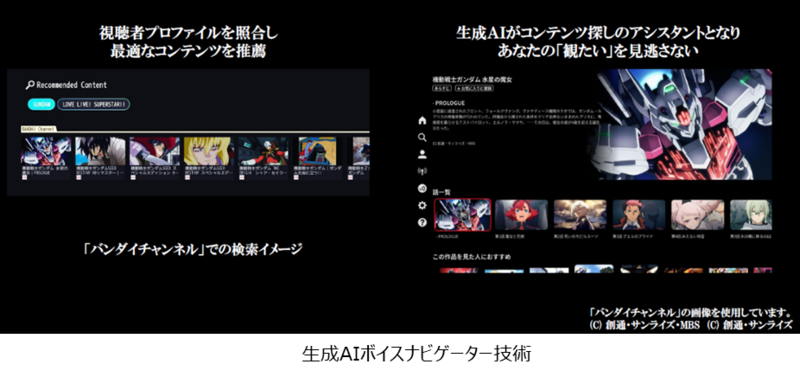

言葉で指示することで、メニュー操作を超えたUIを実現できる点も特徴。バンダイチャンネルのコンテンツを使用したデモでは「〜〜が含まれるコンテンツ」など言葉で作品や番組を絞り込めるほか、候補の中から「左から2番目のものを観たい」など、人が人と話すのに近い感覚で操作できる。

自然言語でやりとりするので、「それで!」とか「ちょっと違う」など曖昧な言葉でも対応してくれる。

使用時にはボイスナビゲートを画面に呼び出す。瞳のような形をしたもので、テレビの前にいる人に反応して、左右に動いたりするビジュアルだ。

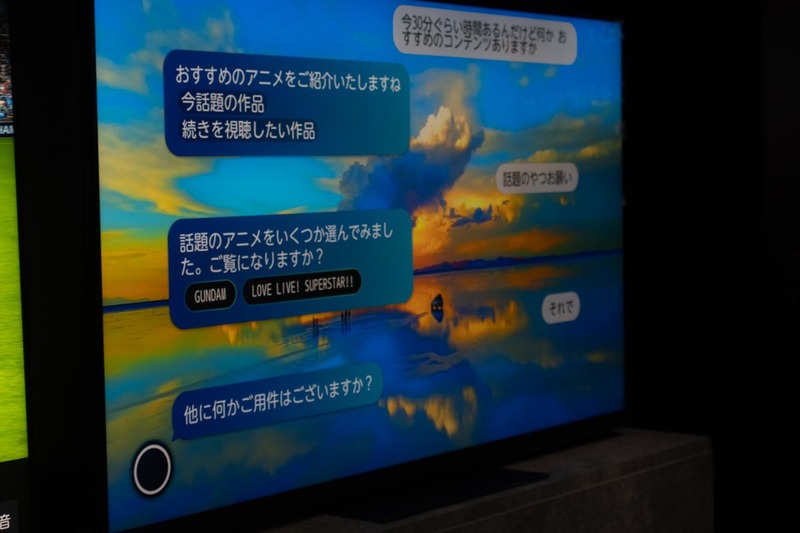

デモでは、レグザに向かって「30分くらい時間があるんだけど、何かおススメのコンテンツはあるか?」と問いかけると、すぐに「今話題の作品」や「続きを視聴したい作品」を示していた。「話題のやつお願い」と返すと、ガンダムやラブライブ! スーパースターなどバンダイチャンネル内のコンテンツをレコメンド。「それで」と話すと、すぐに画面が切り替わって、ガンダム作品が並ぶ。

コンテンツの選択も、この状態で「左から2番目」などというだけと簡単。画面が「機動戦士ガンダムSEED DESTINI HDリマスター」になり、会話だけでコンテンツの絞り込みから再生までが完結した。

生成AIの処理はクラウドで実施し、その結果にあったコンテンツの検索などの処理はローカル(テレビ内の処理)で実施するという。非常にレスポンスが早く、かつ柔軟な受け答えをする点が印象的だった。

対話型の生成AIには現状でもChatGPTやGeminiなどさまざまなものがあるが、自社開発のものも含めて臨機応変に採用できる仕組みになっているそうだ。機能に合わせて適切な組み合わせを選んでいくという。

デモではバンダイチャンネルの協力でガンダムなどのコンテンツを検索できていたが、検索対象としては、まずは「見るコレ」で提供するものが対象となる。そこをベースにしながら横断検索機能を実現していく。製品化の際には、タイムシフトマシン、自動録画などレグザで録画するコンテンツに加えて、さまざまなネット動画やU-NEXTなどアライアンス企業のコンテンツまで検索範囲を広げていくようだ。

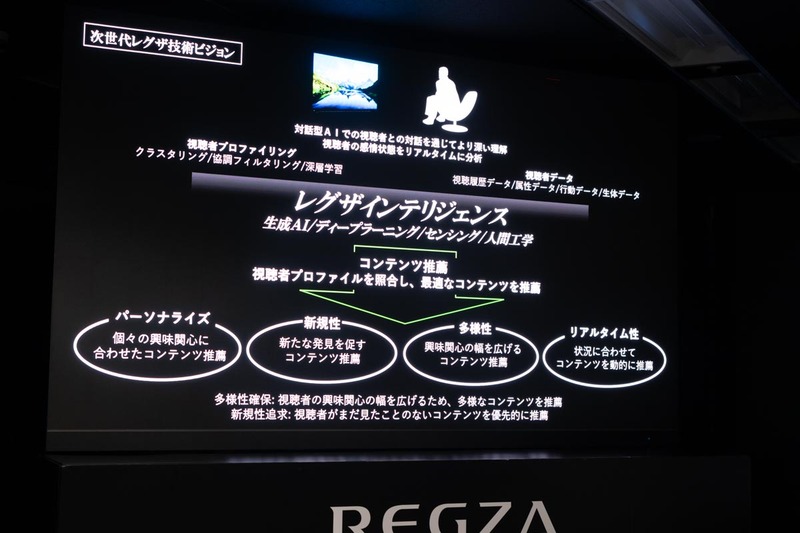

現状では技術展示(コンセプト)の段階だが、センシング技術や趣向を組み合わせて、視聴者の好奇心・価値観・嗜好や属性、さらには感情・体調に合った今見るべきコンテンツを提案。生成AI、ディープラーニング、ミリ波センサーといった技術、人間工学(色や見え方など感性に関係する要素)などの知見に、視聴者のプロファイルを組み合わせて、新しい出会いや発見を促すことを目標としている。

そのときの状況に合わせて、多様でリアルタイム性のある提案を提供。新しい機能を立ち上げていくと言う。

なお、利用者の認識という観点ではプライバシー保護も気になるところだが、今年のデモでは人がいるという認識までにとどめている(誰が立っているかまでは認識しない)という。パーソナライズについては検討課題で、カメラで認識するだけでなく、声質などに応じた判別なども可能とのこと。一方で、プライバシーへの配慮は必須であるため、試行錯誤を繰り返している段階だという。

AIは環境ノイズと音声の分離などにも活用

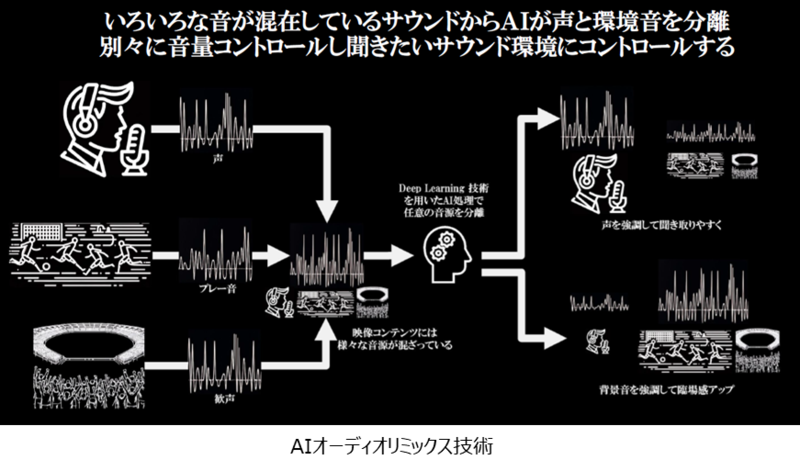

また、最適なコンテンツ再生のためにもAI(ディープラーニング技術)を積極的に活用している。例えば、「AIオーディオリミックス」では、色々な音が混在しているサウンドから「声」と「環境音」を分離し、個別に音量をコントロールして、聞きたいサウンドにできる。

スポーツ実況では歓声とアナウンスの声が同時に鳴って聞き取りがしづらいといったこともよくあるが、アナウンスの声だけを出して歓声を抑えたり、逆に声をほぼ聞こえない(デモでは10%だけ残る設定になっていた)ようにしてスタジアムの臨場感をより感じるといった使い方ができる。

また、屋外のロケなどで騒音がうるさい環境でも、レポーターの声にフォーカスを当てることでより聞きやすく内容を理解しやすくできる。

こういった技術はこれまでもあったが非常に精度が高いのがポイントで、ありがちな声の音色の変化などを感じないのが印象的だった。

110インチの大画面時代だから、ライブに没入したい

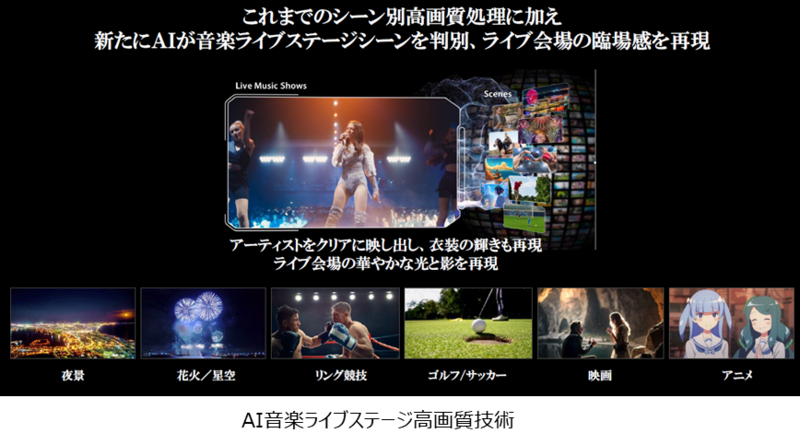

一昨年から継続して取り組んでいるAIシーン高画質も進化。これはシーンをディープラーニングの学習結果から自動判定して、そのシーンにあった高画質化処理を加える技術だが、新たに「AI音楽ライブステージ高画質技術」が加わっている。テレビの大画面が進む中、ライブの臨場感をアップさせ、もっと楽しんでほしいと言う意図で追加したものだという。

具体的には、いま再生しているシーンが何かを認識するプロファイルの中に「音楽ライブステージ」を追加。そう認識した際には、アーティストがより綺麗に見えるようにするという。暗い背景の上に強い光を放つ被写体がある、という意味では、すでにあるボクシングのリングや花火のシーンなどにも近いように感じるが、このモードではステージ全体を見せるような引きのカットでもぼやけさせず、クリアにアーティストを表現できるのが特徴だ。

一方で、アップは目の前にいるような一体感を感じさせる処理とし衣装のキラキラ感なども向上する。解像度処理で、視力が上がったような感じすら得られる。リアリティやライブ感を提供するモードだという。

この記事に関連するニュース

-

より多くの人にAIを学んでもらいAIの活用が進むよう尽力 - 日本ディープラーニング境界 松尾理事長

マイナビニュース / 2025年1月7日 11時15分

-

レグザ、生成AIを活用したコンテンツ検索技術 - CES 2025でデモ展示

マイナビニュース / 2025年1月6日 16時5分

-

進化が加速した生成AI、競争過熱で"AI版ムーアの法則"に限界説も、2025年はどうなる?

マイナビニュース / 2024年12月31日 13時46分

-

Google、Android XRで拡張現実の境界を超える AIとXR、ヘッドセットと眼鏡が開く新たな可能性

東洋経済オンライン / 2024年12月31日 7時40分

-

【無料コード配布中】Aiarty Image Enhancer(AI高画質化ツール) V3.0リリース!より高画質・高速化したAI画像処理技術「More-Detail GAN v3」を発表

PR TIMES / 2024年12月21日 16時15分

ランキング

-

1GeForce RTX 50シリーズ正式発表!前世代から全モデル2倍の性能向上ってマジか

ASCII.jp / 2025年1月7日 15時0分

-

2知って納得、ケータイ業界の"なぜ" 第185回 値引き規制で一層冷え込む2025年のスマホ市場、大きく動くローエンドとハイエンド

マイナビニュース / 2025年1月6日 16時10分

-

3モバイルに「L3キャッシュ爆盛り」とApple/Intel対抗の「GPU強化モデル」登場――AMDが新型「Ryzen」を一挙発表

ITmedia PC USER / 2025年1月7日 6時0分

-

4パナソニックから光学30倍ズームのコンパクトデジタルカメラ ライカレンズと2030万画素のCMOSセンサー搭載

OVO [オーヴォ] / 2025年1月6日 7時41分

-

5HPが「OMEN MAX 16」など「CoreUltra 200HX」に「RTX 50」搭載の新ゲーミングPCを4機種発表

ASCII.jp / 2025年1月7日 13時0分

記事ミッション中・・・

記事にリアクションする

![]()

記事ミッション中・・・

記事にリアクションする

エラーが発生しました

ページを再読み込みして

ください