リコー、日英中3言語に対応した700億パラメータの大規模言語モデル(LLM)を開発、お客様のプライベートLLM構築支援を強化

Digital PR Platform / 2024年8月21日 10時2分

~高速処理と省コストを同時実現し、環境負荷低減にも貢献~

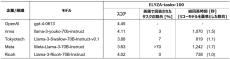

株式会社リコー(社長執行役員:大山 晃)は、お客様の業務効率化や課題解決での活用を目的に、企業ごとのカスタマイズを容易に行える700億パラメータの大規模言語モデル*1(LLM)を開発*2しました。製造業で特に重視される日本語・英語・中国語に対応したほか、お客様のニーズに合わせてオンプレミス・クラウドのどちらの環境でも導入可能です。入力された文章を単語などの細かい単位に分割するトークナイザーの独自改良により、高速処理と省コストを実現し、環境負荷低減にも貢献します。ベンチマークツールを用いた検証*3の結果、優れた性能を確認しました(2024年8月9日時点)。2024年秋から、まずは日本国内のお客様より提供を開始し、今後海外のお客様への提供も目指します。

【プライベートLLMとしてのユースケース例】

社内でも厳しいアクセス制御が求められる機密情報を取り扱う業務

-金融業: 融資審査業務等

-自治体: 行政サービス等

-流通・小売業: 顧客情報分析やマーケティング等

-教育・医療: 長時間労働が課題となっている教員や医師の文章作成等の周辺業務等

日本語・英語・中国語で日々更新される社内文書のデータを利活用する業務

-製造業: RAGを活用した社内情報の検索や要約等

【リコーが開発した700億パラメータLLMの特徴】

①高い日本語性能を持ち、英語・中国語にも対応可能

リコーのLLMは、AIが自然言語の学習に利用するコーパスの選定や、誤記や重複の修正などのデータクレンジング、学習するデータの順序や割合を最適化するカリキュラム学習などリコー独自の方法で学習されています。これにより日本語による安定した回答を実現しました。また、AWS(Amazon Web Services)と共同で開発した学習スクリプトに基づいて訓練されており、日本語、英語、中国語の多様な表現を学習済みです。

さらに、独自開発を含む約1万6千件のインストラクションチューニングデータで追加学習することにより、広範なタスクに適応する能力を獲得しました。これによりお客様のご要望に合わせてプライベートLLMを構築する際の追加学習で生じる破滅的忘却による性能低下を抑制し、高品質なプライベートLLMを開発することができます。

②トークナイザーの独自改良により、日本語の処理効率が同ベースモデルと比較して43%向上

リコーは、テキストをトークン*4に分割しLLMが理解できる形に変換するトークナイザーを独自に改良することで処理効率を向上させました。これにより、リソース削減、レスポンス時間の短縮、省コストを実現しました。LLMは処理に多くの電力が消費され環境負荷が大きいという社会課題に直面するなか、本技術は省エネルギー・環境負荷低減にもつながります。

③セキュリティを確保したオンプレミス環境で、学習~推論までご提供可能

通常、700億パラメータのLLMの運用や学習には、複数のサーバをネットワークで繋ぐ大規模なクラスタシステムが必要となります。リコーのLLMは独自の語彙置換技術やその他の最新技術を活用することによりモデルサイズを保ったまま学習が可能です。セキュリティ面でデータを自社内で保有したいお客様向けには、お客様先のクローズドな環境下での機密情報含めた追加学習が可能です。

④従来手法の開発と比較し、およそ50%のコスト低減および最大25%の電力消費量の削減を実現

「AWS LLM開発支援プログラム」と「AWS 生成AIイノベーションセンター(AWS Generative AI Innovation Center)」によるサポート提供のもと、AWS Trainiumアクセラレーターを搭載したAmazon Elastic Compute Cloud Trn1インスタンスを利用することで、効率的な開発を実現しました。お客様向けカスタムLLMを開発する際にも、より安価・短納期でのご提供が可能です。また、学習に際してTrn1インスタンスを活用することで、同等のアクセラレーテッドコンピューティングEC2インスタンスよりもエネルギー効率を最大 25% 改善しました。

この記事に関連するニュース

-

LenovoのヤンCEOが語る「AI戦略」 Intel/AMD/NVIDIAのCEOも勢ぞろい

ITmedia PC USER / 2025年1月4日 12時0分

-

国産大規模言語モデル「PLaMo Prime」を法人向け生成AIサービス「Tachyon 生成AI」に搭載

PR TIMES / 2024年12月23日 15時45分

-

楽天、日本語に最適化した新たなAIモデルを発表

PR TIMES / 2024年12月22日 22時40分

-

コンタクトセンターのためのセキュアな大規模言語モデル「AOI LLM for AmiVoice Communication Suite」を、ソフトバンクのコールセンターへ導入

PR TIMES / 2024年12月17日 15時45分

-

リコー、生成AIアプリ開発プラットフォーム「Dify」開発元のLangGenius, Inc.と販売・構築パートナー契約を締結

Digital PR Platform / 2024年12月17日 11時2分

ランキング

-

1「大株主として激怒」中居正広さんトラブル報道で“物言う株主”がフジテレビ側に第三者委員会の調査求める

TBS NEWS DIG Powered by JNN / 2025年1月15日 18時2分

-

2「来週会合で利上げ判断」=米新政権政策、賃上げ注視―植田日銀総裁

時事通信 / 2025年1月15日 16時8分

-

3《三菱UFJ銀行》10億円を奪った元行員・今村由香理(46)の夫は“4.5億円資産家”だった 駐車場収入も「奥さんが徴収に来ていましたよ」

文春オンライン / 2025年1月15日 16時0分

-

4裏切られた気持ちでいっぱいです…月収25万円・65歳サラリーマン、毎年「ねんきん定期便」を必ずチェック、年金月19万円のはずが「初めての年金振込日」に知った衝撃事実に撃沈

THE GOLD ONLINE(ゴールドオンライン) / 2025年1月15日 8時15分

-

5防犯カメラ増設、幹部処分へ=貸金庫窃盗で追加策―三菱UFJ銀

時事通信 / 2025年1月15日 19時26分

複数ページをまたぐ記事です

記事の最終ページでミッション達成してください