リコー、モデルマージによってGPT-4と同等の高性能な日本語LLM(700億パラメータ)を開発

Digital PR Platform / 2024年9月30日 11時3分

~お客様のオンプレミス環境でのプライベートLLM導入を加速~

株式会社リコー(社長執行役員:大山 晃)は、米Meta Platforms社が提供する「Meta-Llama-3-70B」の日本語性能を向上させた「Llama-3-Swallow-70B*1」をベースモデルに、同社のInstructモデルからベクトル抽出したChat Vector*2とリコー製のChat Vector*3をリコー独自のノウハウでマージすることで、高性能な日本語大規模言語モデル(LLM*4)を新たに開発しました。これにより、リコーが開発・提供するLLMのラインナップに、米OpenAIが開発したGPT-4と同等レベルの高性能モデルが追加されました。

生成AIの広がりにより、企業が業務で活用できる高性能なLLMのニーズが高まっています。しかし、LLMの追加学習は、コストが高く、時間もかかるという課題があります。その課題に対して、複数のモデルを組み合わせて、より高性能なモデルをつくる「モデルマージ*5」は効率的な開発手法として注目されています。

リコーは、モデルマージのノウハウと、LLM開発の知見に基づき、今回、新たなLLMを開発しました。本技術は、企業独自のプライベートLLMや特定業務向けの高性能なLLMの開発の効率化につながるものです。

リコーは、自社製LLMの開発だけではなく、お客様の用途や環境に合わせて、最適なLLMを低コスト・短納期でご提供するために、多様で効率的な手法・技術の研究開発を推進してまいります。

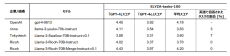

【評価結果*6(ELYZA-tasks-100)】

複雑な指示・タスクを含む代表的な日本語のベンチマーク「ELYZA-tasks-100」において、今回リコーがモデルマージの手法で開発したLLMはGPT-4と同等レベルの高いスコアを示しました。また、比較した他のLLMはタスクによって英語で回答するケースが見られましたが、全てのタスクに対して日本語で回答して高い安定性を示しました。

[画像1]https://digitalpr.jp/simg/2160/95904/600_148_2024092720484466f69b9cd80fb.png

ベンチマークツール(ELYZA-tasks-100)における他モデルとの比較結果(リコーは最下段)

【リコーのLLM開発の背景】

労働人口減少や高齢化を背景に、AIを活用した生産性向上や付加価値の高い働き方が企業成長の課題となっており、その課題解決の手段として、多くの企業がAIの業務活用に注目しています。しかし、AIを実際の業務に適用するためには、企業固有の用語や言い回しなどを含む大量のテキストデータをLLMに学習させ、その企業独自のAIモデル(プライベートLLM)を作成する必要があります。

リコーは国内でもトップクラスのLLMの開発・学習技術をベースに、企業向けプライベートLLMの提供や、社内文書の活用を後押しするRAGの導入支援等、様々なAIソリューションの提案が可能です。

-

-

- 1

- 2

-

この記事に関連するニュース

-

リコー、モデルマージの手法で700憶パラメータの日本語LLMを開発

マイナビニュース / 2024年9月30日 18時29分

-

Meta、無料で商用可のLLM「Llama 3.2」リリース マルチモーダルモデルも

ITmedia NEWS / 2024年9月26日 8時33分

-

Axcxept社、EZO×Qwen2.5シリーズでGPT-4-Turboを凌ぐ日本語LLM/自動CoT・RAGを採用

PR TIMES / 2024年9月24日 15時45分

-

ELYZA、経済産業省およびNEDOが推進する「GENIAC」の支援の元、新たな日本語LLMを開発、成果を公開

PR TIMES / 2024年9月20日 17時40分

-

ELYZA、日本語LLMとしての性能向上を図った「Llama-3-ELYZA-JP-120B」発表

マイナビニュース / 2024年9月19日 16時40分

ランキング

-

1ヤマハ発動機・日高社長が辞任 「家族のケア専念」

共同通信 / 2024年9月30日 18時57分

-

2食べ放題の店で食べ残しを「持ち帰り」しようとしたら罰金と言われました。すでにお金を払っていても持ち帰りはNGでしょうか?

ファイナンシャルフィールド / 2024年9月30日 4時50分

-

31本1500円は当たり前!? 物価高でも高価格シャンプーが売れ続けるワケ

ITmedia ビジネスオンライン / 2024年9月30日 15時0分

-

4GMOあおぞら銀で誤送金 振り込みに遅れも

共同通信 / 2024年9月30日 21時3分

-

5「ドンキでボトムスは売れない」からヒット商品誕生へ 長年の苦戦を変えた2つのこと

ITmedia ビジネスオンライン / 2024年9月30日 15時30分

複数ページをまたぐ記事です

記事の最終ページでミッション達成してください