Cerebras、「NVIDIAのGPUベースより20倍高速」謳うAI推論サービス提供開始

ITmedia NEWS / 2024年8月28日 9時12分

(画像:Cerebras)

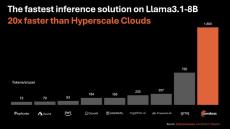

米Cerebras Systemsは8月27日(現地時間)、AI開発者が同社のシステムにアクセスしてアプリを実行できるようにするAI推論ソリューション「Cerebras Inference」を発表した。「米NVIDIAのGPUベースのハイパースケールクラウドより20倍高速」で、はるかに安価だとしている。

Llama3.1 8Bで1秒当り1800トークン、Llama3.1 70Bで1秒当り450トークンを提供し、価格はLama 3.1 8Bで100万トークン当り10セント、Llama 3 70Bで100万トークン当り60セント。

Cerebrasは発表文で、NVIDIAなどのGPUシステムが推論に向かない理由を説明し、自社のシステムは「世界最大のチップを構築し、モデル全体をオンチップに保存することで、メモリ帯域幅のボトルネックを解決する」ことで、GPUのような遅延を解消したと主張する。

Cerebrasのチップは独自のウェーハスケール設計により、44GBのSRAMを1つのチップに統合できるという。総メモリ帯域幅は21ペタバイト/秒で、NVIDIAのH100の7000倍に当たる。

同日から、チャットとAPIアクセスを介してのCerebras Inferenceの提供を開始する。まずはLlama3.1 8Bおよび70Bモデルを提供し、数週間中により大規模なモデルのサポートを追加する予定だ。

Cerebras Systemsは、米国カリフォルニア州サニーベールに拠点を置く2016年創業の非公開企業。AIやディープラーニングの処理専用のコンピュータシステムの開発を手掛けている。

外部リンク

この記事に関連するニュース

-

NVIDIA、日本と台湾で生成AI向けの4つの新しいNIMマイクロサービスを開始

マイナビニュース / 2024年8月27日 18時7分

-

NVIDIA、日本と台湾で生成 AI 向け NIM マイクロサービスを開始

PR TIMES / 2024年8月27日 10時45分

-

Snowflake Cortex AI、Llama 3.1 405Bのホストを発表

マイナビニュース / 2024年8月5日 12時9分

-

Snowflake Cortex AI、Metaとの協力により新たなフラッグシップモデルファミリーホスト・最適化

PR TIMES / 2024年8月2日 12時45分

-

NVIDIA B200搭載 GPUアプライアンスサーバー「NVIDIA(R) DGX(TM) B200」受注開始のお知らせ

PR TIMES / 2024年7月29日 16時45分

ランキング

-

1『ドラクエ3』職業「まもの使い」登場 11月14日発売で予約受付スタート

ORICON NEWS / 2024年8月27日 23時21分

-

2GPS追跡システムに緊急の脆弱性、アップデートを

マイナビニュース / 2024年8月28日 7時32分

-

3「PS5」が価格改定で“大幅”値上げへ 純コンも…SNS反響「すごい値上げ」「コントローラーやば」

ORICON NEWS / 2024年8月27日 15時59分

-

41台で安心! 「コンセントプラグ付きモバイルバッテリー」おすすめ4選 持ち運びやすい小型軽量モデルを中心にピックアップ【2024年8月版】

Fav-Log by ITmedia / 2024年8月28日 6時10分

-

5「ありがとう味の素」 自由研究の質問に“味な神対応”で話題に 「永遠にうれしい記憶が残る」「こんなのファン増えちゃうよ!」

ねとらぼ / 2024年8月27日 20時45分

記事ミッション中・・・

記事にリアクションする

![]()

記事ミッション中・・・

記事にリアクションする

エラーが発生しました

ページを再読み込みして

ください