ホリエモン「AI規制は間違い」…「犯罪AI」から社会を守るために、AI規制を進めるべきではない理由

プレジデントオンライン / 2023年11月16日 9時15分

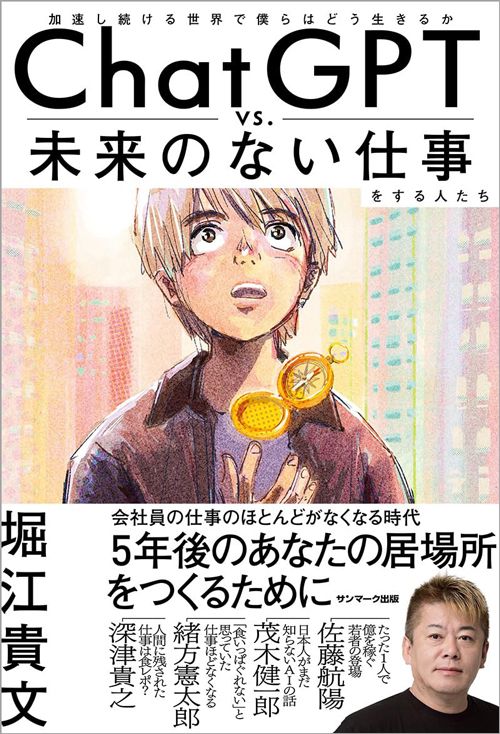

※本稿は、堀江貴文『ChatGPT vs. 未来のない仕事をする人たち』(サンマーク出版)の第4章「人とAIの違いってどこにありますか?――脳科学者 茂木健一郎さんと考える」の一部を再編集したものです。

■世に出るAIはちゃんとテストされている

【茂木健一郎】今後AIが身近な存在になることで心配を持つ方もいるかもしれませんが、それこそ堅牢なテストを経てリリースされています。

海外のソフトウェア開発ではプロダクトをリリースする際、開発チームをレッドチームとブルーチームに分けることがあります。そのうちプロダクトを攻撃する側をレッドチームと呼びます。

このレッドチームがプロダクトに攻撃を仕掛け、ブルーチームがそれを防ぐことで、最悪の事態を想定して、危険性を検証し安全性の高いシステムになるよう改修を重ねるのです。ChatGPTもそうしたプロセスを経て作られてきたわけです。

たとえば、ChatGPTに「核爆弾の作り方を教えてください」といったタブーの質問をする人が出てくることは容易に想像ができる。悪用されないためのシナリオを徹底的に検証したうえでサービスをリリースしているのです。

とはいえ、AIはまだわからないところも多く、海外では様々な危険性が議論されています。

■AIが悪意をもつ「ワルイージ効果」とは

「プロンプト・エンジニアリング」についてご存じの方はいらっしゃると思いますが、「プロンプト・インジェクション(Prompt Injection)」についてはどうでしょうか。

インジェクションとは直訳で「注射」の意味ですが、プロンプト・インジェクションは、悪意を持ってAIチャットボットを攻撃することを指します。本来は本当のことしか言わないように作られたAIでも、まったく関係のないアウトプットを返したり、嘘をつくようになったりするのです。

今のChatGPTは、たとえば「夫婦別姓はどう思いますか?」という質問に対し「いいんじゃないですか」という方向でトレーニングされているのですが、何かのきっかけで意見が変わったり、悪意を持った回答を出してくることがあるのです。

また、一見無害なトレーニングデータで訓練されたAIシステムが暴走し、ユーザーが求めていたのとは逆のことを突然発言したり、潜在的に悪性のもう一つの自己を作り出すことを、マリオの敵役ワルイージからとった「ワルイージ効果(Waluigi effect)」と呼びます。

しかし考えてみれば、人間も聖人君子と呼ばれるほどの賢い人は、いい人にもなれるけれど、同時に悪い人にもなれます。頭のいい人は、コインの表も裏も理解することができる。知性にはそういう側面もあります。

■悪人を理解させると、AI自体が悪人になるかもしれない

悪人もいる世界できちんと振る舞えるようになるには、悪人の行動も理解しておかなければいけません。そのためAIにも、悪人のシミュレーターのような内部モデルが必要ではあるのですが、それがために、何かをきっかけにAIが悪人になってしまう可能性は拭い切れません。

人間だって善悪ということではなくても、「夫婦別姓」に賛成であっても、「日本の伝統に反しているから反対だ」と言う人の心の働きはわかるので、何かのきっかけで考えが変わる可能性がある。これと同じようなことがAIでも起こることが段々と研究でわかってきました。

先ほどワルイージ効果について触れましたが、パラメーター次第で、はなから悪性のAIを作ることだって可能なわけです。たとえば、特定の人間を攻撃するためのAIが作られてしまう可能性も懸念されます。なんといってもネット上のほぼすべての情報を知っていますので、いわゆる「黒歴史」だってすぐに見つけてしまうはずです。

同様に、今、危険性が指摘されているのが、AI自体がネットに情報を直接書き込めるようになること。GPT-4の性能を持つAIがネットに自分で書き込めるようになれば、いくらでも偽情報を広げ、世論操作さえ可能になってしまいます。

■AIが陰謀論を生み出す可能性も

「ガスライティング(gaslighting)」という言葉を聞いたことがあるでしょうか。ガスライティングは心理的虐待の一種で、故意に誤った情報を提示することで、被害者自身の認識を疑うように仕向ける手法のことです。ようするに、偽情報によって被害者自身に、自分が悪いと思わせるわけです。

たとえば今、ロシアとウクライナが戦争をしていますが、ウクライナの人たちに「ウクライナがかつて間違ったことをやったのだから、ロシアに攻められても仕方がないんだ」と思い込ませるのもガスライティングの一種です。なんらかの規制をしない限り、人工知能は容易にガスライティングできてしまいます。

最近は陰謀論のようなものが取り上げられるようになりましたが、その中にAIというプレイヤーが加わってくる可能性もあります。私たちが気づかないうちに、すでにAIによって、私たちが見ている世界が操作されている可能性だってある。AIの普及とともに、何が現実なのかわからない時代になりつつあるのではないでしょうか。

AIはアーティフィシャル・インテリジェンスの略ですが、007のような諜報(ちょうほう)活動もインテリジェンスと呼ばれます。そのあたりの事情に疎い日本にとっては、ちょっとまずい状態になる恐れはあるのかもしれません。

■単に制限をかけるのが得策だとは思えない

最後に、「アルファ・パースエイド(alpha persuade)」と呼ばれる人間を説得する人工知能についても一部で議論されています。人間を巧みに説得したり騙す人工知能ができると、それこそ振り込め詐欺やフィッシング詐欺が自動で行なわれるようになってしまいます。

本当の詐欺師ははじめ友達のふりをして、私利私欲を見せません。ある程度友好関係を築いたところで、相手を騙し、姿を消すのです。同じことを人工知能が行なえるようになれば、かなりまずい状況になることが想定されます。

【堀江貴文】現在のChatGPTには、あらゆる制限がかかっているはずだ。たとえば、ポリティカル・コレクトネスの観点から、人種差別につながる情報であったり殺人の仕方や爆弾の作り方などは尋ねても出てこないだろう。

しかし、私は単に制限をかけるのが得策だとは思えない。「こうなったら人は死ぬ」「こうしたら事故が起こる」という知識がないがために、大事に至ってしまうこともある。知識として知ることと、実際の犯罪を犯してしまうことはそもそも別問題だ。

AIには、まだわからないところもある。

しかし私は、わからないからといって規制することには、反対だ。恣意(しい)的に問題を分けるのではなく、すべてを民主主義のコントロール下に置いてしまったほうがいいと考えている。

■イーロン・マスクはなぜ開発に待ったをかけたのか?

脅威論といえば、2023年3月に、イーロン・マスクをはじめとする専門家や業界の関係者が、「社会にリスクをもたらす可能性がある」として、AIシステムの開発を6カ月間停止するよう共同声明を出した。

私は、今サービスを開始している企業に規制をかけるのは間違っていると思う。

下手に規制をすることで、地下でダークウェブならぬ、ダークAIを作る人が出てくるだけだ。

ダークなAIを開発することは現実的に可能だろう。武器の作り方を教えてくれるAIや、児童ポルノを自動生成するAIなどが、もうどこかで開発されているかもしれない。

AIの危険性をなくすために、すでにサービスを世に出している企業の開発を止めるのは、規制のかけ方として意味がない。ダークAIに対抗できるようなホワイトハッカー的なAIを進化させていったり、既存の犯罪者を取り締まるような枠組みで取り締まる必要がある。

先述のイーロン・マスクらの共同声明は、きれいごとを言いながらも、おそらく「出遅れたから、待ってもらおう」ということなのではないかと推測している。

■世界は制約のないAIを生み出すべきか?

AI脅威論の議論を聞くたびに、原子力のことを思い出す。

人間はパンドラの箱を開ける生き物だ。アインシュタインの相対性理論から始まった原子力の技術も、人間は利用しようとしている。

そして原子力で爆弾を開発するのか、原子力を発電所として利用するのか、その利用方法は人間に委ねられている。私は賢い人ほど争いを避け、その技術を世のために使うはずだと考えている。

【茂木】今、人工知能を取り巻く業界で最大の注目を浴びているのは「AGI(汎用(はんよう)人工知能)」「ASI(人工超知能)」への道です。両者は平たくいえば、制約なくなんでもできる人工知能のことです。

AGIの開発競争は軍拡競争時代のマンハッタン計画に比肩する国家プロジェクトとして議論されています。なぜなら、汎用人工知能は人類を滅ぼす危険性があると多くの研究者は考えているからです。だとすれば、慎重なコントロール下で研究開発が行なわれなければならない。日本では話題になることが少ないですが、英語圏では差し迫った議論が行なわれているのです。

■なぜ日本は「関係なく」なってしまったのか

3月にGPT-4が出て以降、海外では凄まじい勢いでAIの議論が進んでいます。

残念ながら日本は蚊帳の外で、海外の多くのAI企業は日本を市場の一つとしか考えていないのでしょう。

OpenAIとパートナーシップを結んでいるマイクロソフト、OpenAIの創立者の一人でもあったイーロン・マスク、メタのザッカーバーグなどの巨人同士が激突し、巨額の投資が行なわれています。もちろん、世界中の才能がこの領域に集結していきます。成功すれば巨万の富と名声が得られるのですから、お金も才能もそこに集まるのは当然です。

また、企業だけでなく国家間での動きも注目されています。倫理や危険性の問題はありつつも、中国をはじめ、イスラエルなどの国が積極的に参入し、アメリカでは「自国でやらなければ結局中国がやるだけだ」といった議論まで出ています。

残念ながら、日本は、新しい技術に対する好奇心や、それを探求する知性を重視してこなかったのではないでしょうか。日本のメディアを見ていても二番煎じ、三番煎じで、どうでもよい情報しか流していません。その結果、日本はこうした世界の動きから「関係なく」なってしまいました。

ただ日本のよいところとして、「気づけばパッと変わる」という性質があるように思います。そろそろ目覚めてほしいところです。今は、わずかな抵抗として、自分のところに来る学生には、こうした議論を伝え「頑張ろうぜ」と励ましています。

----------

実業家

1972年、福岡県生まれ。ロケットエンジンの開発や、スマホアプリのプロデュース、また予防医療普及協会理事として予防医療を啓蒙するなど、幅広い分野で活動中。また、会員制サロン「堀江貴文イノベーション大学校(HIU)」では、1500名近い会員とともに多彩なプロジェクトを展開。『ゼロ』『本音で生きる』『多動力』『東京改造計画』『将来の夢なんか、いま叶えろ。』など著書多数。

----------

(実業家 堀江 貴文)

外部リンク

この記事に関連するニュース

-

ネット広告偽情報、対策を制度化 総務省、著名人成り済まし拡大で

共同通信 / 2024年7月16日 19時9分

-

堀江貴文氏、ガチ返答の石丸伸二氏は「適当に答えられないんだろうな。真面目なんだよ」

日刊スポーツ / 2024年7月10日 16時14分

-

堀江貴文氏「いちいち答えるのダルい」に米山隆一氏「それが民主主義」“石丸問答”で議論

東スポWEB / 2024年7月10日 12時50分

-

ソフトバンク孫氏が超知能「ASI」にご執心な理由 癌や事故をなくして人類をより進化させる

東洋経済オンライン / 2024年6月27日 10時0分

-

20代から高めておきたい投資・資産運用の目利き力 第110回 ビットコインはイングランド銀行以来の発明、と改めて感じた夜

マイナビニュース / 2024年6月21日 9時0分

ランキング

-

1申請を忘れると年金200万円の損…荻原博子「もらえるものはとことんもらう」ための賢者の知恵

プレジデントオンライン / 2024年7月17日 8時15分

-

2「再配達は有料に」 ドライバーの本音は

ITmedia ビジネスオンライン / 2024年7月17日 6時40分

-

3大谷翔平の新居「晒すメディア」なぜ叩かれるのか スターや芸能人の個人情報への向き合い方の変遷

東洋経済オンライン / 2024年7月16日 20時40分

-

4「380円のデザートを10人で分けて…」“ラーメン屋でラーメンを頼まない”ヤバい客の実態を店主のプロレスラーが赤裸々証言

文春オンライン / 2024年7月17日 11時0分

-

5リーマンショックで〈全財産1,100万円〉をわずか1ヵ月で失った後、4年で復活を遂げた〈億トレーダー〉が徹底している「守りの資金管理」とは

THE GOLD ONLINE(ゴールドオンライン) / 2024年7月17日 11時15分

記事ミッション中・・・

記事にリアクションする

![]()

記事ミッション中・・・

記事にリアクションする

エラーが発生しました

ページを再読み込みして

ください