Netskope、企業のAIアプリ利用に関する調査結果を発表 生成AIアプリに共有されるビジネス上の機密情報の3分の1以上が、規制対象の個人データであることが明らかに

PR TIMES / 2024年7月22日 11時45分

生成AIの利用が過去12カ月で3倍以上に増加し、企業は安全なAI導入とリスク管理の両立という課題に直面

セキュアアクセスサービスエッジ(SASE)のリーディングカンパニーであるNetskopeの調査研究部門であり、クラウド関連の脅威を中心に独自のリサーチを行うNetskope Threat Labsは、米国時間2024年7月17日、企業のAIアプリ活用に関する新たな調査レポート「クラウド・脅威レポート:企業におけるAIアプリ(Cloud and Threat Report: AI Apps in the Enterprise)」を発表しました。本レポートでは、組織が保護に対する法的義務を負う規制対象データが、生成AIアプリケーションで共有されている機密データの3分の1以上を占め、企業にデータ漏えいという、巨額の損失につながり得る潜在的リスクをもたらしていることが明らかになりました。

Netskope Threat Labsの最新の調査によると、調査対象となった企業の4分の3は、現在少なくとも1つの生成AIアプリを完全にブロックしており、これは機密データの漏えいリスクを抑えたいという企業の技術部門リーダーの懸念を反映しています。しかし、入力内容の照会による機密情報の共有を防ぐ目的でデータセントリックな管理策を適用している組織は半数以下です。企業の大多数では、生成AIの安全な活用を実現するために必要な、高度なDLP(Data Loss Prevention、データ損失防止)ソリューションの導入が遅れています。

世界各国が対象となった本調査の結果から、現在、96%の企業が生成AIを使用していることが明らかになりました。この数は、過去12カ月間で3倍の伸びを示した結果です。企業は平均で10近くの生成AIアプリを使用しており、2023年の3から増加しました。また、生成AIアプリの採用数で上位1%にあたる企業では、現在平均して80のアプリを使用しており、14から大幅に増加しています。使用の増加に伴い、企業では機密に該当するソースコードの生成AIアプリ内での共有が急増しており、報告されたデータポリシー違反の46%を占めています。こうした情勢の変化は、企業のリスク管理を複雑なものにしており、より強固なDLPの必要性を示唆しています。

組織が採用を進めているセキュリティおよびデータ損失管理における微妙な差異の中には、予防的なリスク管理という良い兆しが見られます。例えば、65%の企業が、生成AIアプリ上でのユーザー行動をガイドするために、リアルタイムのユーザーコーチングを導入しています。本調査結果から、効果的なユーザーコーチングがデータに関連するリスクの軽減において重要な役割を果たすことが示されており、57%のユーザーはコーチングによる警告を受けた後に行動を変更しています。

NetskopeのCISO(最高情報セキュリティ責任者)であるジェームズ・ロビンソン(James Robinson)は、次のように述べています。「生成AIの安全性を確保するには、さらなる投資と、いっそうの注意深さが求められます。生成AIの利用は企業に浸透しており、その勢いが衰える当面の兆しは見られません。そのため企業は、生成AIの出力を通じて、意図しない機密情報の漏洩や、誤った情報の拡散、さらには悪意あるコンテンツが持ち込まれる可能性すらあることを認識する必要があります。企業のデータ、評判、ビジネスの継続性を保護するための、強固なリスク管理アプローチが求められます」

Netskopeの「クラウド・脅威レポート:企業におけるAIアプリ」では、以下の内容も明らかとなりました。

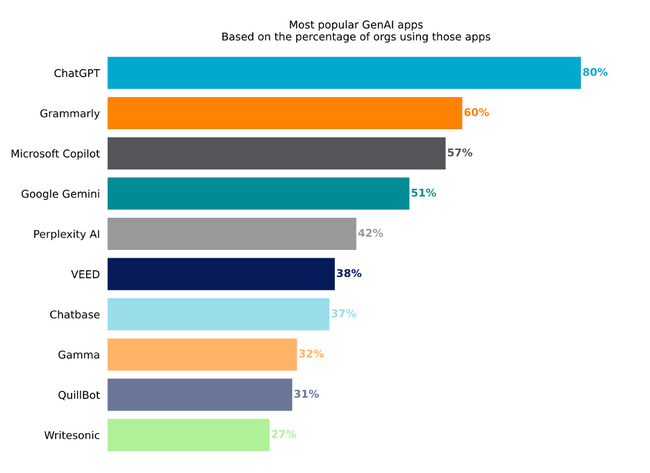

● 最も人気の高い生成AIアプリは依然ChatGPTで、80%以上の企業が利用

● Microsoft Copilotは、2024年1月のリリース以来、57%という劇的な利用率の伸びを示す

● 19%の組織が、GitHub CoPilotの利用を全面的に禁止

[画像: https://prcdn.freetls.fastly.net/release_image/137550/22/137550-22-800d5bf7b966b09f2977b7e200e4f55f-936x680.png?width=536&quality=85%2C75&format=jpeg&auto=webp&fit=bounds&bg-color=fff ]

上図)最も人気の高い生成AIアプリ(アプリを使用している企業の割合に基づく)

企業に向けた重要な推奨事項

Netskopeは各企業に向け、NISTのAIリスク管理フレームワークなどの取り組みを活用し、AIや生成AIに特化したリスク管理フレームワークの見直しと適用、調整を実施することを推奨します。生成AIがもたらすリスクへの対処には、以下のような具体的な戦術的ステップがあります。

● 組織の現状を知る:現状におけるAIや機械学習、データパイプライン、生成AIアプリケーションの使用状況を評価することから始めましょう。セキュリティ管理の脆弱性とギャップを特定してください。

● コアコントロールの実施:アクセス制御、認証メカニズム、暗号化など、基本的なセキュリティ対策を確立しましょう。

● 高度なコントロールのための計画策定:基本的な対策にとどまらず、高度なセキュリティ管理のためのロードマップを作成しましょう。脅威モデリング、異常検知、継続的モニタリング、行動検知などを検討し、通常のユーザーパターンを逸脱した不審なデータの動きを、クラウド環境から生成AIアプリ全体にわたって特定してください。

● 測定、開始、修正、反復:セキュリティ対策の有効性評価を定期的に実施しましょう。実際の経験や新たに出現する脅威に基づき、適応・改良してください。

「クラウド・脅威レポート:企業におけるAIアプリ」のレポート全文は、こちらからダウンロードいただけます。クラウドに関する脅威や、Netskope Threat Labsの最新の調査結果について、詳しくは Netskope's Threat Research Hubをご覧ください。

本レポートは、金融サービス、ヘルスケア、製造、通信および小売業界を含む世界各国の複数の業界における、Netskope Security Cloudプラットフォームのユーザー数百万人から、事前の了承を得て収集された匿名の使用データに基づいています。本レポート内の統計は、2023年6月1日から2024年6月30日までの期間に基づいています。

本プレスリリースは、米国時間2024年7月17日に発表されたプレスリリース(英語)をもとに作成しています。

Netskope Threat Labsについて

業界屈指のクラウド脅威およびマルウェア研究者が在籍するNetskope Threat Labsは、企業に悪影響を及ぼす最新のクラウド脅威に対する発見、分析および防御策の設計を行なっています。クラウドフィッシング、詐欺、マルウェア配信、コマンド&コントロール、データの抜き出しやデータの露出など、クラウド関連の脅威に関する独自のリサーチと詳細な分析を用いることで、同ラボは、ネットスコープのお客様を悪意ある脅威アクターから守り、研究、助言、ベストプラクティスを通じてセキュリティの世界的コミュニティに貢献しています。同ラボはシリコンバレーを始めとする世界各地で企業の設立・経営に携わった経験を持つセキュリティ研究者やエンジニアによって率いられており、本社を拠点に世界中に展開しています。同ラボの研究者は、DefCon、BlackHat、RSAなどを含む最も権威あるセキュリティ会議に定期的に参加し、登壇者およびボランティアとして尽力しています。

Netskopeについて

SASEのグローバルリーダー企業であるNetskopeは、ゼロトラストとAI・MLのイノベーションを適用して、データ保護とサイバー脅威から組織を守ることを支援しています。高速で使いやすいNetskope Oneプラットフォームと特許取得済みゼロトラストエンジンは、場所を問わず、人、デバイス、データに最適なアクセスとリアルタイムのセキュリティを提供します。数千社のお客様が、Netskopeとその強力なNewEdgeネットワークを信頼し、リスクを削減し、あらゆるクラウド、ウェブ、プライベートアプリケーションのアクティビティにわたって比類のない可視性を獲得しています。これにより、セキュリティとパフォーマンスをトレードオフなしに実現しています。詳しくは、netskope.com/jpをご覧ください。

本件に関する報道関係者からのお問い合わせ先

Netskope 広報事務局 (合同会社NEXT PR内)

TEL: 03-4405-9537 FAX: 03-6739-3934

E-mail: netskopePR@next-pr.co.jp

企業プレスリリース詳細へ

PR TIMESトップへ

この記事に関連するニュース

-

生成AIやLLMにより高度化するフィッシング、どう対抗するか 第1回 企業の生成AI活用におけるメリットとリスクとは

マイナビニュース / 2024年7月16日 9時52分

-

Netskope、ガートナー シングルベンダーSASE部門のマジック・クアドラントでリーダーの1社に初の認定

PR TIMES / 2024年7月12日 14時45分

-

ネットスコープ、通信業界のクラウドアプリを標的としたサイバー脅威レポートを公開

PR TIMES / 2024年7月2日 15時45分

-

パロアルト、「Prisma SASE 3.0」発表 - 目玉は独自セキュアブラウザ提供

マイナビニュース / 2024年6月27日 9時27分

-

Netskope調査で、CISOがより前向きにリスクと向き合う意識が明らかに

PR TIMES / 2024年6月25日 13時45分

ランキング

-

1システム障害、世界で余波続く=欠航、1400便超

時事通信 / 2024年7月21日 22時45分

-

2コメが品薄、価格が高騰 米穀店や飲食店直撃「ここまでとは」

産経ニュース / 2024年7月21日 17時41分

-

3円安は終わり?円高反転4つの理由。どうなる日経平均?

トウシル / 2024年7月22日 8時0分

-

4なぜユニクロは「着なくなった服」を集めるのか…「服屋として何ができるのか」柳井正氏がたどり着いた答え

プレジデントオンライン / 2024年7月22日 9時15分

-

5ウィンドウズ障害、便乗したフィッシング詐欺のリスク高まる…復旧名目に偽メール・偽ホームページ

読売新聞 / 2024年7月22日 0時0分

記事ミッション中・・・

記事にリアクションする

![]()

記事ミッション中・・・

記事にリアクションする

エラーが発生しました

ページを再読み込みして

ください