世界初、AIモデルの再学習コストを大幅に削減可能な過去の学習過程を再利用する「学習転移」を実現 ~NTT版LLM「tsuzumi」など基盤モデルの更新・差し替えを容易に~

Digital PR Platform / 2024年5月7日 15時13分

発表のポイント:

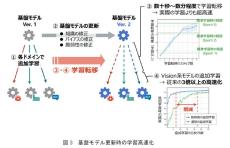

深層学習において、過去の学習過程をモデル間で再利用する全く新たな仕組みとして「学習転移」技術を実現しました。

本技術は、深層学習におけるパラメータ空間の高い対称性を活用し、実際に学習することなく低コストな変換により数秒~数分程度で一定の精度を実現できるため、モデルの再学習コストを抜本的に削減できることを示しました。

これにより、NTTが研究開発を進める大規模言語モデル(LLM) 「tsuzumi(*1)」をはじめとした多様な基盤モデル(*2)の運用コスト削減・消費電力の削減や、多数のAIで議論することで多様な解の創出をめざしたAIコンステレーション(*3)の構想具現化など、次世代のAI技術開発に貢献します。

日本電信電話株式会社(本社:東京都千代田区、代表取締役社長:島田 明、以下「NTT」)は、深層学習において過去の学習過程をモデル間で再利用する全く新たな仕組みとして「学習転移」技術を実現しました。本技術は、ニューラルネットワークのパラメータ空間における高い対称性を活用し、過去の学習過程のパラメータ列を適切に変換することにより、新たなモデルの学習結果を低コストで求めることを可能にします。これにより、生成AIなど大規模な基盤モデルを用途毎に追加学習(以下、チューニング)して利用する場合に不可欠な、基盤モデルの定期的な更新に伴う再チューニングコストを大幅に削減でき、生成AIの運用容易化や適用領域拡大、消費電力の削減に貢献することが期待されます。

なお、本成果は2024年5月7日から11日まで、オーストリア・ウイーンで開催される機械学習分野における最難関国際会議International Conference on Learning Representations (ICLR) 2024 (*4) において発表されます。

1.背景

近年、生成AIとして多様かつ大規模な基盤モデルが利用可能となり、各企業や組織内の要件に対応するため、個々のデータセットでの追加学習により基盤モデルをチューニングして活用することが一般的となっています。しかし、このチューニングは基盤モデルの更新時や異なる基盤モデルへの変更時に再学習が必要となり、多大な計算コストが生じることが課題となっています。例えば、基礎性能の改善や著作権・プライバシー問題など脆弱性への対応により基盤モデル自体が更新されると、それをチューニングして得られていたモデルすべてに対して再度チューニングを実施する必要があります。また、市中で多様な基盤モデルが利用可能となってきていますが、性能向上やコスト削減のために基盤モデルを変更しようとする際には、移行先の基盤モデルで再度チューニングを行う必要があります。

生成AIを活用していく上で、これらチューニングコストは無視できないものであり、将来の生成AIの普及に対して大きな障壁となることが予想されています。

この記事に関連するニュース

-

スーパーコンピュータ「富岳」で学習した大規模言語モデル「Fugaku-LLM」を公開

PR TIMES / 2024年5月10日 17時15分

-

富士通など8者、富岳で学習した130億パラメータのLLM「Fugaku-LLM」を公開

マイナビニュース / 2024年5月10日 14時43分

-

連合学習において一部のクライアントに異常や悪意がある場合にも高精度にAIモデルを学習可能な手法を開発 ~LLM tsuzumi の学習への適用やIOWN機能としての実用化を目指す~

Digital PR Platform / 2024年5月7日 15時10分

-

オルツ、数兆パラメータ規模の大規模言語モデル構築に着手

PR TIMES / 2024年4月26日 17時15分

-

オルツ、数兆パラメータ規模の大規模言語モデル構築に着手

共同通信PRワイヤー / 2024年4月26日 15時0分

ランキング

-

1飲むヨーグルトが「乳酸菌バブル」でジリ貧の理由 市場は逆転寸前、かつての人気を取り戻せるか

東洋経済オンライン / 2024年5月19日 7時20分

-

2東京から新幹線…「新神戸」よりも、一駅先の「西明石」まで買った方がおトク!? JR往復割引「601キロ」のカラクリ

まいどなニュース / 2024年5月19日 8時2分

-

3ラーメン屋経営で地獄見たプロレスラーの気づき 川田利明が向き合う「お客様は神様です」の怖さ

東洋経済オンライン / 2024年5月19日 12時30分

-

4ローソン、コーヒーなどの「濃さ」選べる仕様に 背景に“客離れ”回避

ITmedia ビジネスオンライン / 2024年5月19日 8時0分

-

5広がるタッチ決済乗車は訪日外国人観光客対応か 話題の「二重価格」が鉄道・バスに導入される可能性

NEWSポストセブン / 2024年5月19日 7時15分

複数ページをまたぐ記事です

記事の最終ページでミッション達成してください